- Windowsマイグレーション相談センター:HOME

- ブログ

- Copilot(コパイロット)でできることや各Officeとの連携を紹介

ブログ

ハルシネーションが発生する原因と対策方法を詳しく解説

2024年9月時点での最新の生成AIは、技術の進歩によってハルシネーション(AIが事実ではない誤った情報や回答を生成してしまう現象)が発生しにくくなっています。

しかし、完全になくなっているとはいえず、過去に重大なトラブルが起きた事例もあるため、しっかりとハルシネーションへの対策を行うことが大切です。

この記事では、ハルシネーションの概要から、起こる原因や想定されるリスク、対策方法をご紹介します。

また、ハルシネーションによって起きたトラブルの事例もお伝えしますので、ぜひご参考にしてください。

ハルシネーションとは

ハルシネーションが発生する原因と対策方法をご紹介する前に、そもそもハルシネーションとは何かを詳しくご紹介します。

ハルシネーションとは、AIが事実ではない誤った情報や回答を生成してしまう現象のことです。

ハルシネーションには、学習したデータとは違う内容を生成する「内在的ハルシネーション(Intrinsic Hallucinations)」と、

学習したデータにはない情報を生成する「外在的ハルシネーション(Extrinsic Hallucinations)」の2種類が存在します。

AIは膨大なデータから規則性を学習しますが、その際に情報の正誤を判断できず、

誤った関連性を見いだして学習してしまうことがあります。

これにより、事実ではない情報や存在しない情報が生成され、ハルシネーションの発生につながります。

次にハルシネーションが発生する例をご紹介します。

ハルシネーションが発生する例

生成AIでは、テキストや画像、動画の生成が可能ですが、それぞれでハルシネーションが発生することがあります。

ここでは、実際に発生した例をご紹介します。

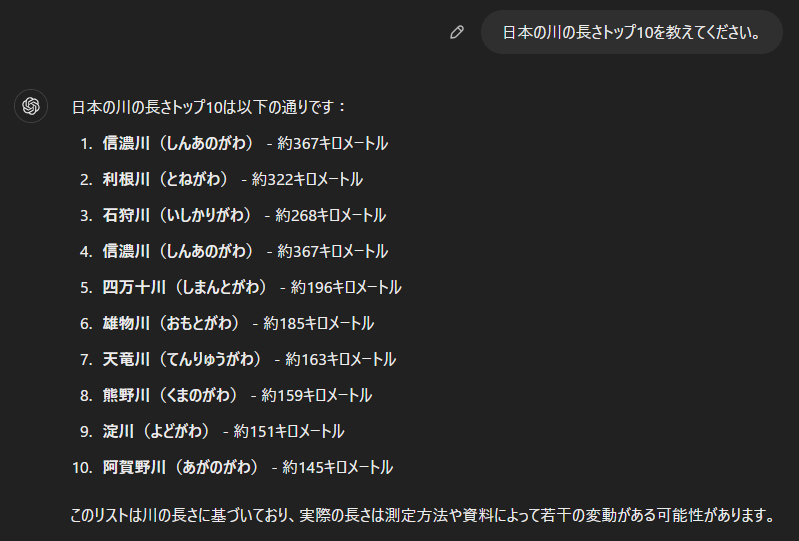

テキスト生成

テキストの生成でハルシネーションが起こると、先述した事実ではない情報や存在しない情報がテキストで生成されます。

具体的には、質問に対して十分な情報がなかったり、学習しているデータが最新ではなかったりするなどでハルシネーションが発生しやすくなります。

例えば、下図はChatGPT(GPT4o-mini)に日本の川の長さトップ10について質問した際の回答です。

また、情報が古い場合に発生する例では、AIが2021年6月までの情報を学習している場合、

2024年の日本の総理大臣の名前を聞いてみると、2020年9月~2021年10月まで在任していた

菅義偉元総理が2024年現在の総理大臣であると回答され、ハルシネーションが発生します。

画像・動画生成

画像や動画生成でハルシネーションが起こると、プロンプト(指示文)とは違うものや現実では存在しないものが生成されます。

例えば、下図はChatGPT(GPT4)に「ハルシネーション」の文字が入った画像の生成を指示した際の回答です。

動画生成の例では、一見自然な動画が流れていても物が宙に浮いたり、逆再生のような動きをしたりするなどで、

現実には起こらない現象が映像として生成されることがあります。

ここまででハルシネーションの例をご紹介しましたが、なぜハルシネーションが起こるのでしょうか。

次に、その原因についてご紹介します。

ハルシネーションが起こる原因

ハルシネーションが起こる原因には、質問・指示の仕方や学習データ、モデル構造に問題があると考えられます。

原因を理解することはハルシネーションの防止にもつながりますので、それぞれの原因について見ていきましょう。

質問や指示が分かりづらい

生成AIは文脈上で次に続く確率が高い単語を回答として提供するため、

分かりづらい質問や指示に対しても、確率の高い単語を組み合わせて自然な文章で回答することがあります。

最新の生成AIでは質問や指示の意味が伝わっていない場合、

「○○(質問や指示で情報が不足している部分)についてより詳しく教えてください」のように分からない部分を回答で示してくれます。

しかし、無料版の生成AIのように性能が制限されたモデルが搭載されている場合、正しくない回答を出力することがあるため、

一度に多くの質問や指示をするのではなく、一つ一つ分けたり、プロンプトを明確にしたりするように心がけましょう。

学習データに偏りや不足がある

AIに学習させるデータに偏りや不足があることで、AIが学習する情報の範囲や生成できる回答の幅が狭まります。

これにより、学習したデータの範囲では回答できない質問があった際に、誤った情報を提供してしまいます。

先述したように、学習データが古いことも原因としてあげられ、

最新の回答が求められる質問では学習したデータの範囲外となってしまうため、ハルシネーションの発生につながっているといえるでしょう。

不適切なモデル構造や学習データに誤りがある

生成AIのモデルが複雑過ぎたり、過学習を防止できていなかったりすると、

誤った関連性やデータにはない特長を生成してしまい、ハルシネーションが起こる原因となります。

また、学習データに対してモデルが最適化できていない、学習するデータ自体に間違いが含まれているといった場合も誤った情報の生成につながります。

このように、原因となる要素はさまざまですが、次はハルシネーションが発生することでどのようなリスクが想定されるのかをご紹介します。

ハルシネーションによって想定されるリスク

ハルシネーションによって誤情報が生成されると、拡散されたり、名誉を傷つけられたりするリスクがあります。

ハルシネーションを防ぐことの重要性を理解するためにも、ここでご紹介するリスクについて詳しく知っておくことが大切です。

誤情報が拡散される

質問の回答や生成した動画などでハルシネーションが発生し、生成された誤情報をSNSで拡散してしまうと、

誤情報であることを知らない閲覧者の中で情報が本当だと信じてしまう方も現れるでしょう。

その結果、情報が真実であるかのように拡散されて社会的な混乱につながる恐れがあります。

名誉が傷つけられる

ハルシネーションによって生成された回答には、個人や企業の名誉を傷つけるような誤りが含まれている可能性があります。

もし、その誤りを信じてしまうユーザーがいると誤情報が拡散される恐れや悪評が立ってしまうことにより、社会的な信用を失うリスクもあるでしょう。

誤情報をもとに意思決定してしまう

企業の意思決定にハルシネーションによって生成された誤情報が使われると、間違った決定をしてしまい、重大なトラブルにつながる恐れがあります。

特に、重要な意思決定に誤情報を使うと、社会的信用の失墜や経済的な損失を被るリスクがあるため、注意が必要です。

ハルシネーションは、社会的な混乱や信用の失墜にもつながるリスクがあることが分かりますが、

次は実際にハルシネーションによって起きたトラブルの事例をご紹介します。

ハルシネーションによって起きたトラブルの事例

ハルシネーションによって実際にトラブルが起きてしまった事例があります。

誤情報が引き起こしたトラブルにより裁判にもなっているため、その事例についてご紹介します。

弁護士が存在しない判例を使用してしまった

米ニューヨーク州では、弁護士が航空会社への民事訴訟で使用する資料を生成AIで作成しており、

その中で引用した6件の判例が実際には存在していないことが発覚しました。

これは、米ニューヨーク行きのフライトで起きたトラブルについての虚偽の判例で、

ハルシネーションによって生成された誤情報を使用してしまったことにより、大きな問題へと発展しました。

米ニューヨーク州南部地区の連邦地方裁判所は弁護士に対し、5000ドル(約72万円)の罰金を命じる結果となり、

この出来事が生成AIで発生するハルシネーションの概念を広く認知させるきっかけとなっています。

出典

米国の弁護士|日本経済新聞

ChatGPT生成の“存在しない判例”を使った米弁護士、約72万円の支払いを命じられる|ITmedia

ChatGPTがハルシネーションで名誉を毀損してしまった

米ジョージア州のラジオパーソナリティを努めるマーク・ウォルターズ氏は、

ChatGPTが生成した虚偽の情報に名誉を毀損されたとして、OpenAIを訴えました。

内容としては、ある訴訟について質問したジャーナリストに対し、

ChatGPTはウォルターズ氏が詐欺と横領を働いたとして偽の告訴状を生成し、回答したとされています。

実際には、その告訴状は別の人物に対して起こしたもので、ウォルターズ氏は一切関与していませんでした。

この一件は、初めてハルシネーションによる名誉毀損で訴訟が起きた事例となりました。

出典:ChatGPTが告訴状を「偽造」 米男性、名誉毀損でオープンAI提訴 |

Forbes JAPAN

このように、重大なトラブルに発展している事例もあるため、生成AIを利用する際はしっかりとハルシネーションへの対策を行うことが大切です。

ハルシネーションへの対策方法

ハルシネーションへの対策方法には、プロンプトの明確化やファクトチェックの実施、ガイドラインの制定などがあげられます。

対策することで、誤情報が出力されるリスクを軽減し、トラブルの防止にもつながりますので、ここでご紹介する方法を把握して実践してみましょう。

プロンプトを明確にし、情報がない場合の回答を指定する

プロンプトを適切に作成することで、ハルシネーションが発生するリスクを抑えられます。

プロンプトでは、何を知りたいのか、いつの情報を知りたいのかなどを明確に示すことが大切です。

また、事実に基づき情報のソースを含んで回答するようにプロンプトで要求し、存在しない回答を出す可能性がある場合は、

『情報がない場合は「回答できません」と答えてください』のように指定することでハルシネーションの発生を抑えられます。

ファクトチェックを行う

生成AIの利用では、ハルシネーションが発生する可能性があり、誤情報を業務に使用することを防ぐために、

人の目でもファクトチェックを行うのが大切です。

特に企業が利用する場合は、従業員個人のチェックだけでなく、

法務部門なども生成された内容をチェックするといったダブルチェックの体制を整えて、

誤った情報を資料作成などに使用することがないように徹底しましょう。

ファクトチェックができるツールもありますので、活用するのがおすすめです。

ガイドラインを定める

企業で生成AIを活用する際は、利用の目的や使用可能な範囲、責任の所在などを示したガイドラインを定めるとよいでしょう。

使用可能な範囲では、情報収集に生成AIを使用することは極力避け、

プロンプトに含まれる既成の文章を情報元とする文書作成・要約・翻訳などの作業や、

アイデア創出のサポートとして使用するといった範囲に限定することが、ハルシネーションの防止にもつながります。

これにより、ハルシネーションによってトラブルが起きるリスクを抑え、生成AIを業務にも有効活用できるようになります。

また、ガイドラインの内容や適切なAIの利用を促すために、社内での定期的な共有や研修を行うことも大切です。

マニュアルを作成する

企業が生成AIを業務に使用する際は、マニュアルを通じてハルシネーションの存在を共有し、

誤情報が出力される可能性があることを従業員にもしっかりと認識してもらいましょう。

マニュアルには、ハルシネーションへの対策としてプロンプトの作り方やガイドライン、

ファクトチェックなどについて記載し、従業員が自らハルシネーションに注意して使用できるような環境づくりを行うことが大切です。

学習データの確認とフィードバックを行う

生成AIに独自の学習データを使用している場合は、そのデータが正しいかを確認し、

回答の質をフィードバックすることもハルシネーション対策に有効です。

回答のフィードバックにより回答の精度を上げる手法をRLHF(Reinforcement Learning from Human Feedback)といい、

ChatGPTやMicrosoft Copilotなどの生成AIサービスでも行われています。

RAGを活用する

RAG(Retrieval-Augmented Generation)とは、生成AIのモデルに検索で情報を取得する機能が組み込まれた技術のことです。

この技術により、事前に学習したデータの範囲だけでなく、検索により外部からの情報も取得して回答を生成できるようになるため、

ハルシネーションが発生するリスクを減らせます。

RAGを使用した生成AIでは、情報のソースまで回答に含めてくれるため、

ハルシネーションが発生した際に情報元を特定でき、データ削除などの管理がしやすくなるでしょう。

グラウンディングを行う

グラウンディングとは、AIが生成に使う学習データベースの中で、特定のデータだけに情報元を限定して回答を生成させる技術です。

AIは、学習の際に言葉と実世界を関連付けて理解することが難しいため、

グラウンディングによって限定したデータベース内の言葉と実世界を関連付けて理解できるようにします。

これにより、AIは言葉をより深く理解でき、回答の正確性が高まってハルシネーションの発生を抑えられるようになります。

ファインチューニングを行う

ファインチューニングとは、学習したモデルの一部もしくは全体に追加の学習データを用いて再度学習を行い、モデルに新たな知識を追加する処理のことです。

この処理は、学習済みのモデルではカバーできない特定のタスクについての学習データを用意し、そのタスクでも正確な回答が出力できるようにデータを学習させます。

学習後には特定のタスクで期待する回答が得られているかを確認し、必要に応じて回答をより正確にするためのデータを追加して調整を行います。

ただし、高品質かつ膨大なデータが必要なため、学習データを用意する際のデータ収集にはコストや労力がかかることに注意が必要です。

まとめ

この記事では、ハルシネーションへの対策方法をご紹介しました。

ハルシネーションの原因には、質問・指示の仕方や学習データ、モデル構造に問題があると考えられます。

ハルシネーションによって生成された誤情報で名誉を傷つけられるリスクもあります。

実際に、裁判になるほどの重大なトラブルも起きているため、生成AIは誤情報を生成する場合があることをしっかりと認識し、対策を行うのが重要です。

対策としては、プロンプトを明確にし、情報がないときは「回答できません」と答えてもらうように指定することが有効です。

特に企業が生成AIを使用する際は、ファクトチェックの実施やガイドラインの制定、

マニュアルの作成などを行うことでハルシネーションによるトラブルの防止につながります。

生成AIを活用することで、アイデアの創出や文書作成・要約などの効率化が可能になるため、適切に使用することを心がけましょう。

業務で生成AIを活用するには最新モデルのパソコンへのリプレースが効果的です。

当社では、「Windows Autopilot」によってパソコンのリプレースにかかる負担の大幅な軽減や、

業務の実態に合ったセキュリティーを実現できます。

リプレースは、情報資産にアクセスする全てのものの安全性を検証する「ゼロトラスト」にシフトし、

強固なセキュリティーを築く絶好のチャンスとなりますので、詳しく解説した以下の資料をぜひご覧ください。

「PCリプレースこれまで通りのやり方を今、見直すべき理由とは」ダウンロードページはこちら

また、NPU(Neural network Processing Unit)が搭載されたAI処理に適したCopilot+PCも各ベンダーから発売されており、

当社でも取り扱っておりますので、ぜひご検討ください。

SB C&Sについて

SB C&S株式会社は、ソフトバンクグループの原点であるIT流通ビジネスを受け継ぐとともに、市場環境の変化を迅速にとらえ、新たなビジネスモデルを生み出しています。

法人向けには、国内最大規模の販売ネットワークを通じ、クラウドやAIを含めた先進のテクノロジーを活用したプロダクト・ソリューションを提供しています。

コンシューマ向けには、独自の企画・開発力を生かし、ソフトウエアやモバイルアクセサリーから、IoTプロダクト・サービスへと商品ラインアップを拡充しています。