【特集 Azureを使ってIoTをはじめよう】

ビッグデータのストリーミング処理基盤「Event Hubs(イベントハブ)」とは

2016.07.27

大量のデータを取り込む「Azure Event Hubs」

あらゆる「モノ(Things)」がインターネットにつながり、モノから収集されたビッグデータを処理、分析することで新たなビジネス価値を生み出すIoTの取り組みに注目が集まります。今注目を集めるIoTは、インダストリー領域では、機械や設備に組み込まれたセンサーから収集されるデータで生産工程や品質管理を自動化し、モノづくりを進化させる「インダストリー4.0」を実現するための重要な要素です。

一方、コンシューマー分野では、モバイルアプリなどにおけるユーザーの行動履歴のトラッキングやWebサーバーの大量のトラフィック分析のように、同時に接続している多数のデバイスやアプリケーションから送られてくる膨大な量のデータを、安全かつ確実に処理することが欠かせません。

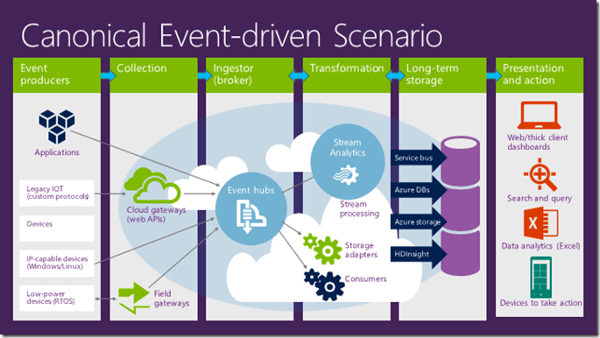

こうした課題に対し、大量のデータを取り込むためのストリーミング処理サービスを提供するのが「Azure Event Hubs」です。Event Hubsは、1秒間に数100万件ものイベントを取り込むことができる拡張性と信頼性の高いデータ受信サービスで、大量のデータを処理・分析できます。

1つのイベントを複数のクライアントで同時に取り出すことができるので、たとえば、サーバーのパフォーマンスログを複数のデバイスでリアルタイムに並行処理するといったことも可能です。

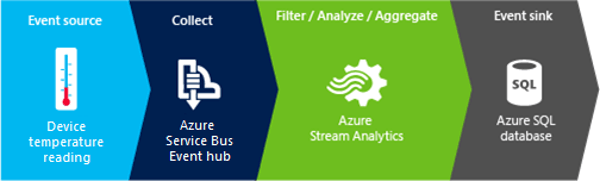

これは文字通り「ハブ」として機能するもので、データ加工の「Stream Analytics」や、データを格納する「SQL Database」と組み合わせて使うことにより、Event Hubs に収集されたデータは、任意のリアルタイム分析プロバイダーや、ストレージ アダプターを使用して変換、格納されます。

また、格納されたデータを「Machine Learning」や「Power BI」などで分析、可視化するといった使い方も可能です。

Event Hubsは、IoTによって生成されるビッグデータ解析において、デバイスから送られてくるセンサーデータの入口として使うことができるほか、アプリケーションの実装、継続的なユーザーエクスペリエンス(UX)の提供、ワークフロー処理などの利用シーンで利便性を発揮することが期待されています。

Azureを使ってリアルタイムに大量のデータを収集し分析したいときに、欠かせないサービスの1つです。

photo:Thinkstock / Getty Images