みなさんこんにちは。

2024年5月に開催されたMicrosoft Buildではさまざまな製品・サービスに関するアップデートが発表されました。 このうち、SLMならびにPhi-3に関するアップデートが気になったという方もいらっしゃるのではないでしょうか。 今回はPhi-3の概要について、Azure AI Studioに関する説明を交えつつご紹介いたします。

本ブログ記事はPhi-3に関するものではございますが、一部Azure OpenAI ServiceのGPTを例にご説明している箇所がございます。 Azure OpenAI ServiceのGPTについては基礎的な内容を以前のブログ記事でご紹介しておりますのでご参照ください。

SLM と Phi-3

Azure OpenAI Serviceで提供されているGPTは一般に「LLM」(Large Language Model、大規模言語モデル)に分類されます。 LLMは大量のデータを用いて学習され、自然言語を表現するために多数のパラメータを持ちます。 パラメータが多いほど、モデルはより複雑な自然言語の表現を理解したり生成したりすることができます。 GPT-4の正確なパラメータ数は公表されていませんが、Microsoft Learnでは1.4兆と推定されています。 精度や汎用性といった面での利点がある一方、「大規模」言語モデルであるが故にGPTを稼働させるには潤沢なコンピューティングリソースが必要です。

Microsoft社は以前からSLM(Small Language Model、小規模言語モデル)として「Phi」と呼ばれるAIモデルを開発していました。 パラメータ数が少なく軽量という特徴があります。 軽量であるため、クラウドだけではなくエッジやデバイスなど(潤沢なリソースが用意できない環境)で利用する道も広がります。 レイテンシーを抑える手として検討されるケースもあるでしょう。

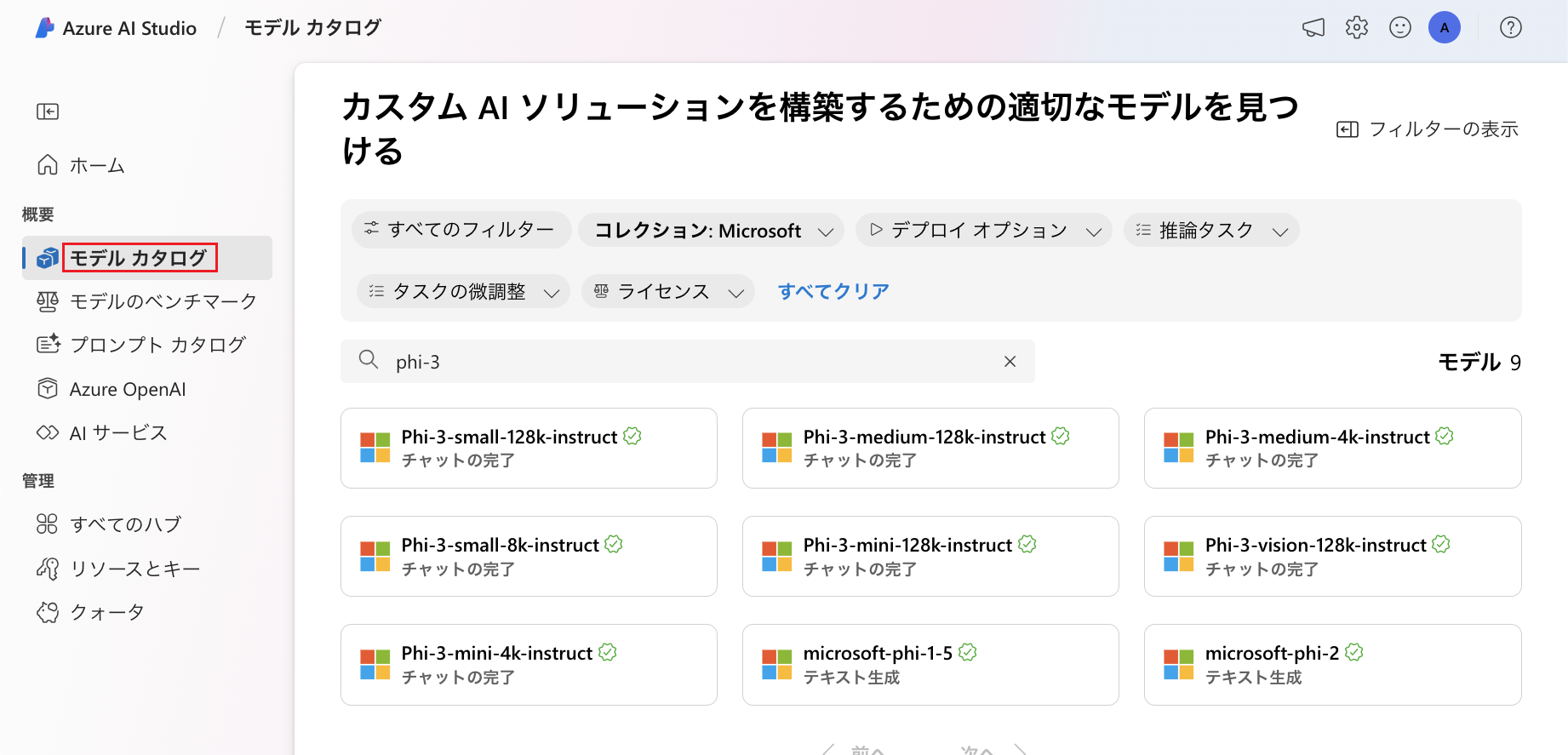

現在、Phi-3には4種類のモデルがあります。

| Phi-3-vision | 42億パラメータ、マルチモーダル (コンテキスト長: 128k) |

| Phi-3-mini | 38億パラメータ (コンテキスト長: 4kまたは128k) |

| Phi-3-small | 70億パラメータ (コンテキスト長: 8kまたは128k) |

| Phi-3-medium | 140億パラメータ (コンテキスト長: 4kまたは128k) |

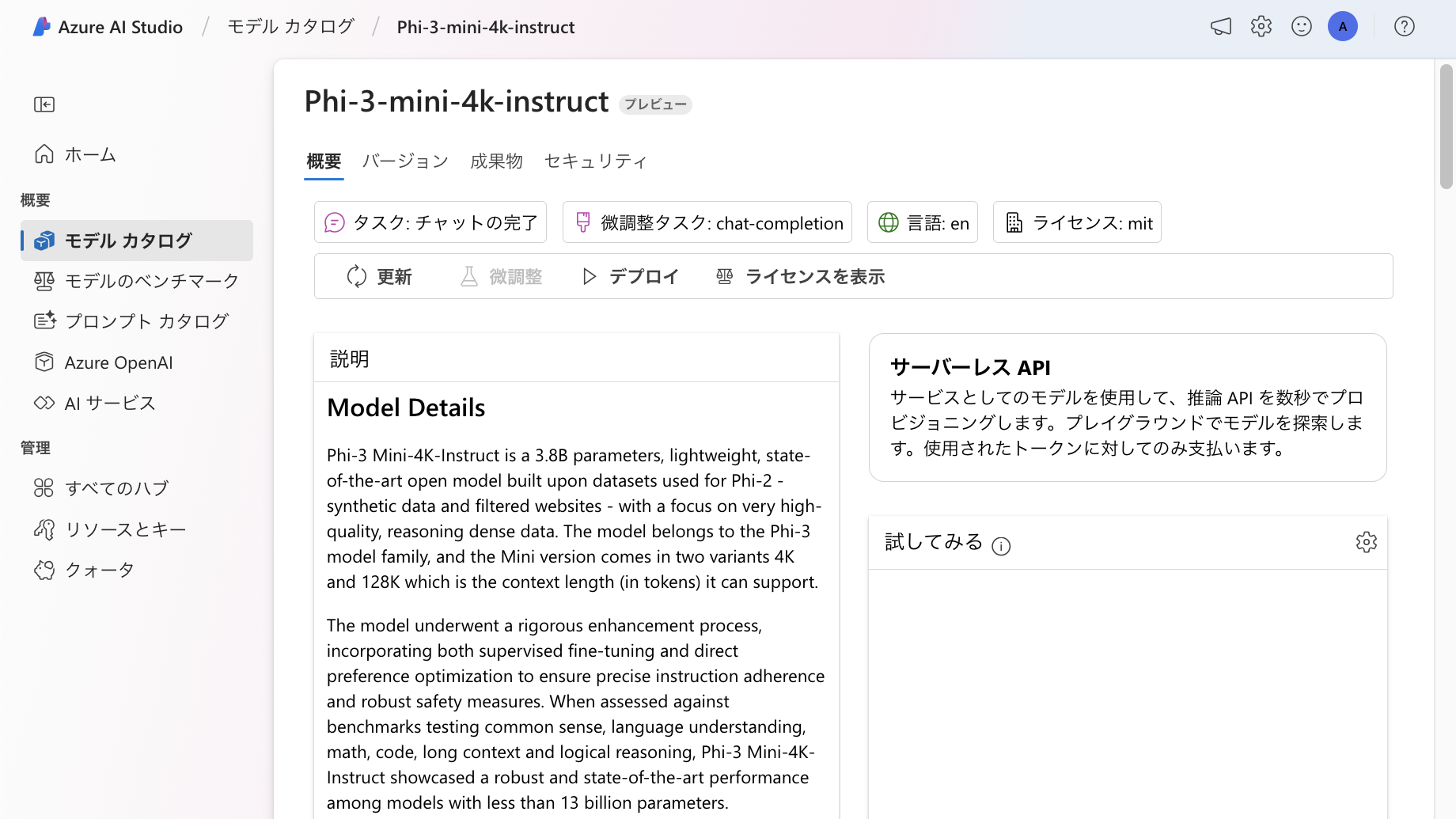

各モデルの詳細情報については、Azure AI Studioのモデルカタログで確認できるようになっています。

モデル名に含まれる「4k」や「128k」といった表記はコンテキスト長を表しています。

任意のモデルをクリックすると、以下のようにモデルの詳細情報を確認することが可能です。 以下は「Phi-3-mini-4k-instruct」の画面です。