こんにちは。SB C&Sの幸田です。

NVIDIA Networking ご紹介の連載1回目、まずは「AI基盤に求められるネットワーク」がどのようなものなのかをご説明します。

Deep Learningを中心とした大規模な演算処理を行う現代のAI基盤ならではの要件を把握していただくと、次回以降で詳しくご説明するNVIDIA Networkingの各プロダクトを利用する必然性をスムーズにご理解いただけるかと存じます。

AI基盤のデータセンターはネットワークが極めて重要

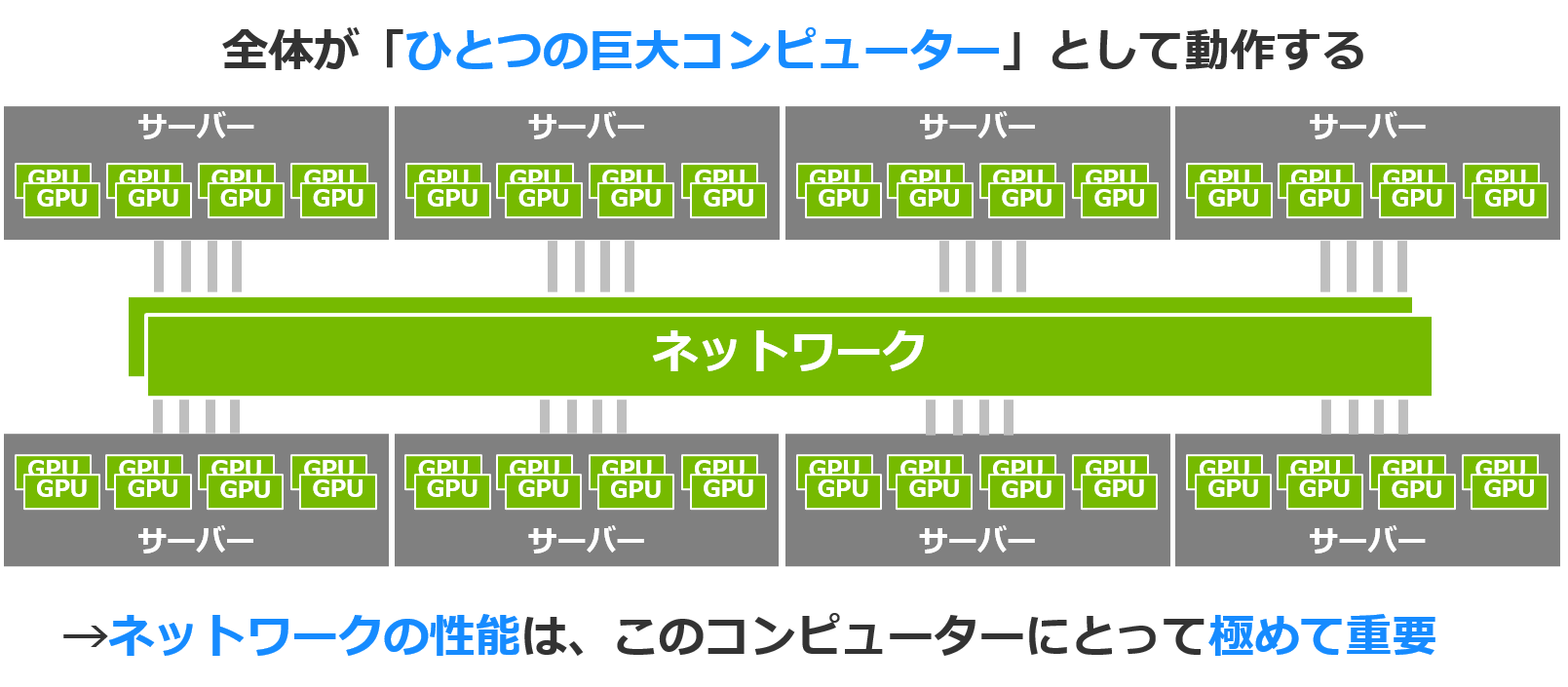

大規模言語モデルをはじめ、昨今における各種AIのモデル開発では、単一のサーバーに搭載されたGPUには収まりきらない多くのパラメーターや膨大なデータを扱って演算を行います。

このような演算を円滑に処理する必要があるため、複数のGPUサーバーを並列化したデータセンターを1台の巨大なコンピューターとみなして処理を行います。

単一のサーバー内に搭載されているGPU間は、サーバー筐体内の内部接続によって通信を行います。内部接続は伝送距離が短いこと、またNVLinkを中心としたテクノロジーの開発をNVIDIAが以前から進めていることもあって、高速な通信が可能です。

対して、サーバー間を接続するネットワークは、スイッチやケーブル、トランシーバーによって接続されます。このネットワークについても「内部接続との性能差が少ない、より高速なものにできるか否か」が、データセンターを巨大コンピューターに見立てた場合の性能に極めて大きな影響を与えます。

つまり、「ネットワークがデータセンターを定義する」といえるほどに重要な要素なのです。

East-West(ノード間)通信の重要性と、求められる要件

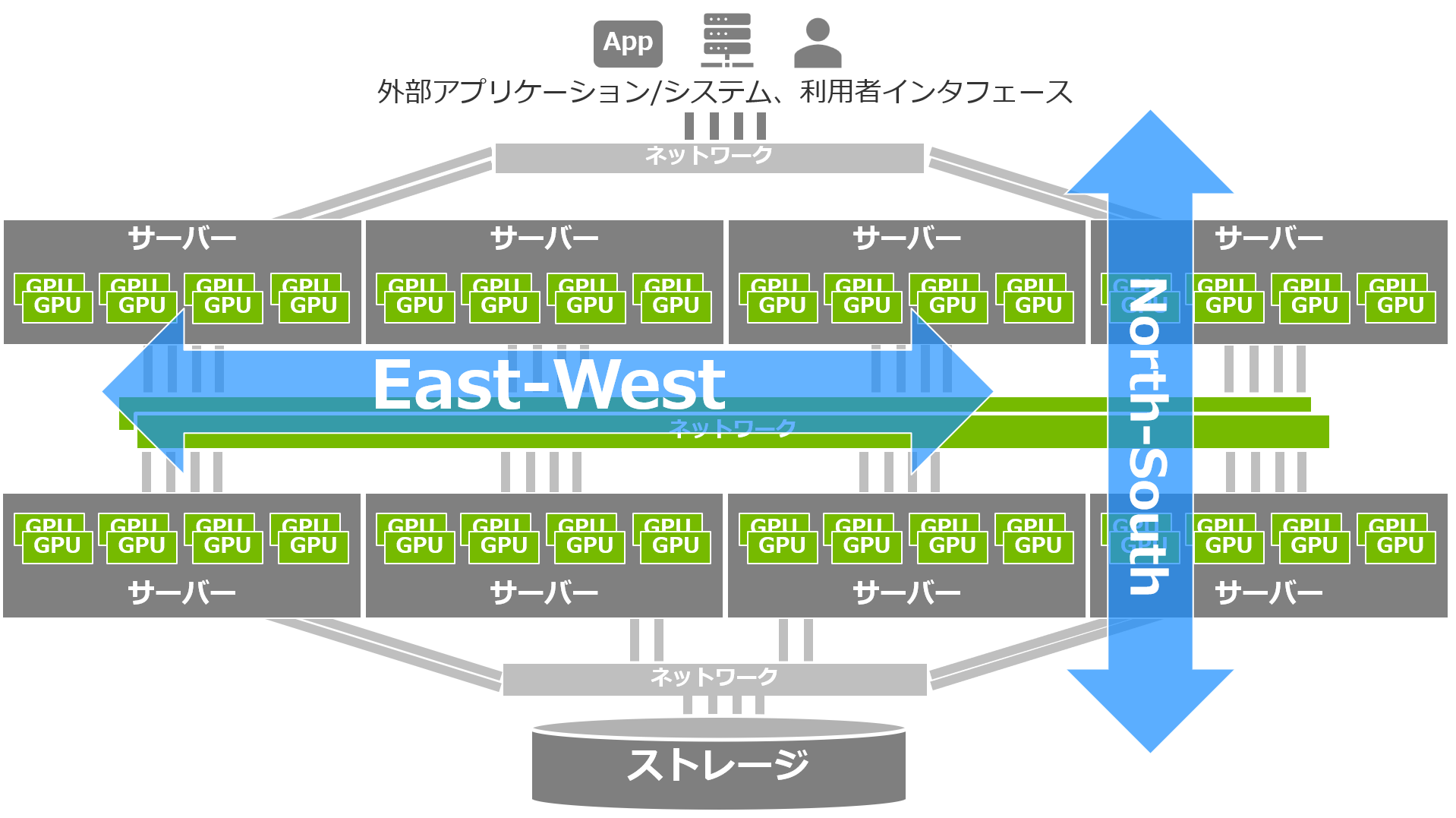

一般に、ノード間の通信をEast-West, ストレージや外部システム、利用者インターフェースとの通信をNorth-Southと呼びます。

特にAI基盤においては、East-Westにあたるノード間、すなわちサーバー内部・外部ともにGPU間の通信をいかに高速化・効率化するかが重要です。

このAI基盤におけるEast-Westの通信には、どのような性質が要求されるのでしょうか。主なものを以下にピックアップします。

低遅延であること

各サーバーの演算は協調して動作します。このとき、GPU間で膨大なデータのやり取りが行われます。

データの時間の遅延が大きくなると、全体性能に大きく影響を及ぼすため、非常に低遅延な通信が行えることが求められます。

帯域を無駄なく使うこと

従来のネットワーク技術では、用意された帯域の大半が無駄になっていることも多くありました。

膨大なデータのやりとりが発生するAI基盤のネットワークにおいては、このようなロスを極力減らすことが求められます。

輻輳をコントロール可能なこと

先述のとおり、全体が協調して動作する必要があるため、一か所の遅延が処理全体の遅延を招きます。

当然ながら、輻輳により発生する大幅な遅延を生じさせないことが求められます。また、輻輳の回避は帯域を無駄なく使うことにもつながります。

NVIDIA Networkingのプロダクトは、まさにこれらの要求に対応できるネットワークを構成することが可能です。次回以降、InfiniBand, Ethernetそれぞれについて、実装されている具体的なテクノロジーの解説をしてまいります。

著者紹介

SB C&S株式会社

ICT事業本部 技術本部 技術統括部 第2技術部 1課

幸田 章 - Akira Koda -

NVIDIA製品を中心としたコンピューティング(グラフィックス, AI/HPC)とネットワーキング、VDI を含む仮想化、クラウド等のプリセールス・エンジニア業務に従事。

VMware vExpert 2015-2022