| NetApp INSIGHT 2024 開催概要 |

| Keynote Day1 |

Keynoteが行われる場所はイベント会場の中でも一際大きくきらびやかなステージになっています。

昨年と同じく、司会の方が会場を盛り上げ、ボルテージがMAXになったところでNetAppのCEOであるGeorge Kurian氏が登場します。

Keynoteは、NetApp INSIGHTの開催期間中に全3回の公演があるのですが、

今年のKeynoteは「AIとデータへのチャレンジ」とそれを実現する新製品やサービスの紹介が中心になっており、1日目のKeynoteではAIワークロードを取り巻く変化やそれに適応してきたNetAppの事例について、さまざまな業界のプロフェッショナルと対談する流れになりました。

George Kurian氏は、NetAppが掲げる大きなビジョンの1つとして昨年に引き続き、「INTELLIGENT DATA INFRASTRUCTURE」という言葉を強調し、この1年間のAIに関する変化について、AIシステムの言語理解や非構造化データの分析が可能になったことを上げ、データに対する分析レベルが飛躍的に向上したことを説明する一方で、過去の時代から変わらないことは「データそのものの重要性」だとし、そこに対してチャレンジを続けるNetAppの優位性について強調しました。

そして、今後さらなる進化を遂げるであろうAIについて、その障壁となる課題と、それを攻略するための話を中心としてセッションが進んでいきます。

ビデオメッセージ:Microsoft

ご存じの通り、MicrosoftとNetAppはAzure NetApp Files(以下:ANF)をはじめとする様々なサービスを提供しています。

Satya Nadella氏は、現在のIT業界がAIプラットフォームを変革する真っ只中にいること、データ主導でAIに対応できる企業こそが、この先の膨大なチャンスを掴むための最も有利な立場になれることを強調し、今年のNetApp INSIGHT開催について賛辞を送りました。

対談①:Microsoft Azure

Girish Bablani氏は、企業がAIを上手に利用する方法として、「パフォーマンスとセキュリティ」が重要であるとし、コカ・コーラ ボトラーズジャパンの事例を交えてANFであればそれらが実現できることを主張しました。

【コカ・コーラ ボトラーズジャパン 事例】

・世界最大級のSAP環境をわずか5か月でANFへ移行

・DR環境におけるフェイルオーバー時間が90%短縮

・アプリケーションのレスポンスが40%向上

・トータルコストが30%削減

※事例詳細はこちらをクリック

また、今後の展望としてMicrosoft Copilotと連携したデータ戦略について検討したいことにも触れ、Microsoft とNetAppのパートナーシップがより強力になる事を伝えました。

Microsoft Copilotは、組織内のデータを活用してメール文章やPPTの提案資料作成、Excelでの図表描画など、私たちの業務を手助けしてくれるAIツールです。

NetAppのストレージやANFにあるデータを利用できるのであれば、Girish Bablani氏が強調したようなパフォーマンスとセキュリティが伴ったAIシステムの強化につながりそうですね。

また、AIを導入する上での課題として、データサイエンティストがLLM(大規模言語モデル)のアルゴリズムをより良い物に向上させようと考える一方で、深層学習に使われるデータの取り扱いやガバナンスに対してはあまり注目されていないと話し、不特定多数のユーザーがAIによって不適切な形で機密性の高いデータにアクセスすることがないように制限を設けたり、データの鮮度や正当性を担保することで、常に最新の情報を提供するといったことも同時に実現することでLLMのメリットを享受することができ、AIシステム全体の進化が進むと説明しています。

さらに、AI導入におけるもう1つの課題として「AIシステムの複雑さ」についても触れています。

現在、多くのAIシステムは日々の運用に利用されているシステムではなく、AI専用に切り離されサイロ化したシステムからデータを受け取っているため、オンプレミスやクラウドなどデータの利用箇所が増えることによって、データの収集や統合、それらを行うためのステップが複雑になっていると言います。

実際に一般的なAIシステムのワークフローを見せ、その中でも特に「DATA CONDITIONING」に多くの時間がかかることを説明し、それを解決するための3つの価値をNetAppが提供できると主張しました。

【一般的なAIシステムのワークフロー】

【DATA CONDITIONINGを具体化した図】

【NetAppが提供するAIワークフロー簡略化における3つ価値】

・Effectively understand and manage your data for AI

⇒データを効果的かつ安全に管理すること

・Bring AI to your data

⇒環境を問わず、普段利用しているデータをAIに導入すること

・Deliver the power of AI efficiently

⇒AIでの出力結果を整理/効率化させる多くの機能を提供すること

ここからはNetAppのSVPであるKrish Vitaldevara氏へバトンが渡り、上記で説明した価値を提供するNetAppの最新ソリューションについての紹介が始まります。

Krish Vitaldevara氏は、NetAppのソリューションを使ったAIシステムは多種多様なワークロードで使われているが、顧客が求める要件はどこもあまり変わらないとし、NetAppが選ばれているポイントについて以下の5つを上げました。

【AIシステムにNetAppが選ばれる5つのポイント】

① コストを抑えること

② オンプレ、クラウドなど環境問わずデータが扱えること

③ データの移動が安全かつスムーズであること

④ マルチクラウドに対応していること

⑤ エコシステムとして他のソリューションと連携できること

ちなみに上記のポイントを見たとき、NetAppが大好きな皆様も感じたことだと思いますが、これらのポイントは何もAIのために急ごしらえで作られたのではなく、創業当初からNetAppが掲げている「データファブリック」という環境問わず自由にデータを取り扱うためのビジョンのもと、年々製品や機能がアップデートされてきた結果ですよね。

つまり、AIという市場が拡大される前からすでにNetAppでは必要な準備が整っていたんだと思い、長期的な未来に対してビジネス戦略を練るNetAppの先見の明を感じました。

とはいえ、もちろんこのまま何もしなくて良いということはありません。

Krish Vitaldevara氏は、一般的に1つ顧客が利用するAI環境の課題としてデータをコピーする環境やワークフロー、AIに利用するためのツールなどが多すぎることを上げ、顧客のAIにおけるインフラ要件と、それを満たすためにNetAppが提供する3つの価値について説明しました。

【一般的に顧客が扱うAI環境】

・データのコピー先が7か所以上

・AIに関連するアプリケーションが13か所以上

・Vector DBの負荷が大きい

【AIにおけるインフラ要件】

① 拡張が容易でかつコストが最適化されたインフラ

② データをAIに組み込むための統合データエンジン

③ データへのアクセス/移動/処理/管理がセキュアであること

④ ハイブリッド/マルチクラウドへの対応

⑤ シンプルなエンドツーエンドのソリューション

・・・・・

これを聞いて皆さん「そうかなるほど!」ってなりましたでしょうか?

私はところどころピンとこなかった(AIについての知見がない自分が悪い)のですが、要は「拡張性とセキュリティが高く、ハイブリッド/マルチクラウドにも対応できる超簡単なAIソリューションがほしい!」ってことだと思います。

そして、顧客の要件を満たす3つの価値として「AI要件を満たすインフラの提供」「セキュアかつ堅牢なデータエンジン」「その2つを組み込んだAIサービス」を紹介しました。

先ほどの要件に照らし合わせると①④がインフラの提供、②③がデータエンジン、⑤がAIサービスということだと私は理解しました。

そして今回、AIに関するインフラ要件を満たすため、BlueXPにAIソリューションが組み込むビジョンがあることが発表されました。

BlueXPはNetAppのストレージ(オンプレ/クラウド問わず)やサービスを一元管理する統合ツールです。

今回、新たな機能の例として発表されたBlueXP Data explorerを利用することで、様々な環境にデプロイされたNetAppストレージから多種多様なデータを1つのネームスペースとして管理し、それらをNetAppのAIエンジンのもとで構造化することで、膨大なデータを自然言語を用いて簡単に参照/検索したり、機密データへのアクセス制限をかけたり、さらにはAIシステムに必要なデータをまとめてNetAppのAIエンジンへの組み込み、またAPI連携などへ利用したりと様々なことが可能になります。

【BlueXP Data explorer】

【指定した条件に該当するファイルを一覧化】

・BlueXPからONTAP内のデータを探索する

【抽出したファイルをデータコレクションという形でグループ化】

【データコレクション単位でAIツールへ連携可能:図はAPIを利用した場合】

これらの素晴らしいことは、AIシステムのために専用のデータ基盤を新しく用意するのではなく、既存のデータ基盤にAIシステムを連携させることで、不要なワークフローやコストの削減が可能であるとともに、NetAppのユーザーが難しい技術を習得することなくAIを利用できるという部分にあります。

これはまさに、Krish Vitaldevara氏が説明していた課題や顧客要件を満たすために最適なツールだと感じました。

※こちらは構想段階の機能になります。

新機能としてGAされているわけでないことについてご留意ください。

対談②:Johnsons & Johnsons

3人目のゲストは、Johnsons & Johnsonsでデータサイエンスに関する研究開発のDirectorを務めるMonica Jain氏です。

Monica Jain氏は、生成AIを用いたビジネスの拡大を統括する立場として、特に医療業界だからこそデータの品質や正確性の担保に加え、データを取り扱うガバナンスが非常に重要であると説明し、だからこそハイブリッドクラウドが最適であると紹介しました。

例えば、クラウドを利用することで容量などを最適化しながら使用できることや、機密性の高いデータはオンプレミスで管理するなど、バランスのとれたシステムを構築できると話し、George Kurian氏も「AIのユースケースとして非常に良い例だね」と答えました。

さらに具体的な例として、機密性が低く演算処理が必要なデータ、アナリティクスやモデルのトレーニング用データなどはクラウドに配置し、治験データや患者データなど、厳格な規制の対象になるデータについてはオンプレミスに配置していると紹介し、クラウドとオンプレミスのデータ連携が必要になった時もシームレスにデータを連携(レプリケーションやキャッシュ、階層化など)できることがNetAppの最大の強みだと語っています。

対談③:AWS

Microsoftと同様にAWSとNetAppは強力なパートナーシップのもと、様々なクラウドサービスをリリースしています。

Matt Wood氏は、AWSとNetAppの代表的なサービスであるFSx for NetApp ONTAPについて、顧客から選ばれる理由の1つにパフォーマンスとセキュリティの高さがあると説明しました。

また、生成AIで成功するにはクラウド利用による柔軟性とセキュリティやプライバシーなどのトレードオフが必要とされている中で、FSx for NetApp ONTAPならその2つを両立できるとし、自社の優位性について熱く語ってくれました。

ここまでの内容でも分かるように、AIというワークロードにおいて「パフォーマンスとセキュリティ」という2つが非常に重要な要素になっているのは明白ですね。

登壇されたどの企業の方も、違った立場からAIについて議論してくれましたが、最終的な結論は同じものになっていると感じました。

魅力的な対談は全て終わり、最後にGeorge Kurian氏からあらためて「AIにおけるデータ戦略」と「データエコシステムとビジネスエコシステムを補完的に利用すること」についての説明がなされ、1日目が終了します。

| Keynote Day2 |

2日目のKeynoteでは、NetAppのEVP & Chief Product OfficerであるHarv Bhela氏による進行で、NetAppの各プロダクトチームメンバーと一緒に新しい製品ポートフォリオを紹介する流れとなっていました。

Harv Bhela氏は、この1年でNetAppが実現してきたイノベーションにおける4つの柱として以下を説明しました。

【イノベーションの4つの柱】

① エンタープライズストレージ

・最適化されたパフォーマンスと機能性

・AFF Aシリーズの新モデルリリース

② クラウドストレージ

・価格とパフォーマンスの両立

・Google Cloud NetApp Volumesをリリース

③ セキュリティとデータ保護

・Autonomous Ransomware Protectionなどの圧倒的なランサムウェア対策

④ AI領域

・AI専用プラットフォームのリリース

ここから、スピーカーがNetAppのSVP & GMであるSandeep Singh氏に移り、イノベーションをさらに強化するための新製品の紹介がスタートします。

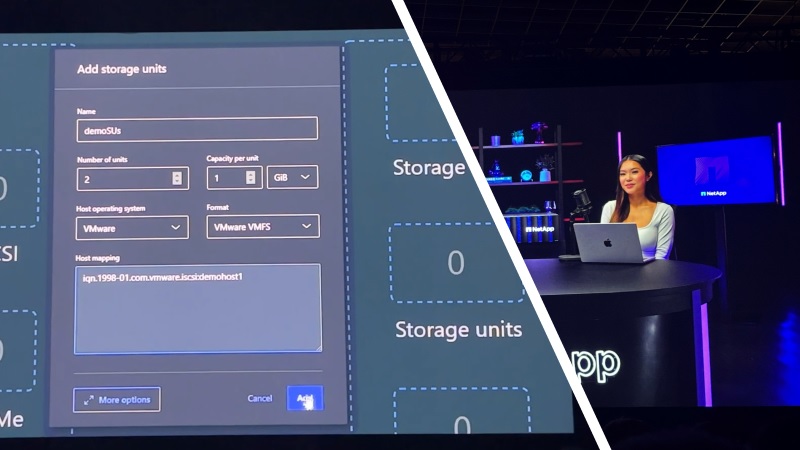

ASA Aシリーズ(新モデル)

直近の6月にリリースされたAFF Aシリーズのハイエンドモデルと同じく、パフォーマンスに特化した製品で「ASA A70」「ASA A90」「ASA A1K」の3つのモデルがあります。

また、ハイパフォーマンスだけでなく従来のASAシリーズと同様、SANに最適化されたことによるシンプルさと低価格でお届けが可能という他社と競うための協力なメリットを併せ持っています。

実際にNetAppに詳しくないインターン生にASAシリーズを使用したストレージユニットの作成を実施してもらい、1分もかからずデプロイされる様子が検証ビデオで流れるなど、シンプルさの部分を強く主張していました。

※ASA Aシリーズの最新モデルのスペック等は下記の製品紹介ページからご確認ください。

ASA Aシリーズ 製品紹介

ASA Aシリーズ オンラインマニュアル

FASシリーズ(新モデル)

エンタープライズワークロードにおいてコストは押さえつつ、バックアップや階層化(Fabric Pool)、サイバー保管庫(SnapMirror+SnapLock+ARP)として機能性を持たせたセカンダリストレージを導入する際のベストプラクティスとしてリリースされました。

例えば、物理的にNW遮断をするエアギャップでは、プライマリストレージからの侵入を防ぐことはできますが、セカンダリストレージへ直接侵入されるケースにはどう対応するのでしょうか?

そんな時、NetAppならストレージそのものが豊富なランサムウェア対策機能を搭載しているため、管理者権限の乗っ取りなどコア部分を攻撃されることにも対応できます。

NetAppでは論理的なエアギャップと言っていますね。

今回の発表でフロントベゼルも全て一新され、代々続くNetAppストレージのアップデートが1つの形で完了したのかな?と感じました。

Pravjit Tiwana氏は、NetAppのクラウドストレージがもたらしてきた成長性を語りつつ、今後フォーカスしていくクラウドストレージ市場について説明しました。

【WORKLOAD READY】

・全てのワークロードに対応できるストレージを提供する

・NetApp BlueXP Workload Factory VMware to AWS EC2 Migration Planningの公開

※NetApp BlueXP Workload Factoryの最新記事はこちらをクリック

【AI READY】

・FSx for NetApp ONTAPとBedrock(AWSのAI用フルマネージドサービス)の連携

※上記に関する記事はこちらをクリック

・Azure NetApp FilesとOneLakeの連携

※OneLakeと連携することでAzure AI SearchやOpen AIへのデータ連携が以前よりスムーズになります

・Google Cloud NetApp VolumeとVertex AIの連携

※上記に関する記事はこちらをクリック

【COST OPTIMIZED】

・最小1TiBからのデプロイ

・オブジェクトストレージへの自動階層化

・最大35%のコスト削減が見込める1年 or 3年のReserved価格

【HYBRID CLOUD】

・DR環境としての利用

・SnapMirrorを使用したクラウドシフト

対談④:Google Cloud

Sameet Agarwal氏は、Google Cloud NetApp Volume(以下:GCNV)のフルマネージドサービス化やGenAI Tool Kit for Google Cloudなど、この1年でリリースした製品の振り返りとともに新たな取り組みについても語ってくれました。

Sameet Agarwal氏はGoogle Distributed Cloud(以下:GDC)とNetAppの連携について以下のような構想を述べました。

GDCは、Google Cloudの柔軟性を求めるも環境要件などでクラウドストレージの利用に制限があるユーザーのため、Google Cloudのいくつかの機能をサポートしたオンプレミスサーバーをラックごと貸し出すサービスです。

そのようなユーザーに対してGDCと一緒にNetAppのエンタープライズストレージを導入することで、パフォーマンスとセキュリティを備えたシステムを提案できるのではと踏んでいるようです。

また、GenAI Tool Kit for Google CloudとVertex AIの評価が高まっていることにも触れ、GCNVと連携することでオンプレミスのONTAPやCVOのデータをVertex AIで利用できる可能性について語りました。

これが実現すると、NetAppのストレージが存在する場所にGenAI Tool KitなどのAIツールを持っていくことで、その場でAIシステムが構築できるようになるため、本記事で何度もお伝えしているような少ないステップで簡単にAIを利用するというNetAppの1つの目標に到達できるような気がします。

個人的には、GenAI Tool Kitが直接オンプレミスのONTAPやCVOにアクセスできるとさらに利用の幅が広がると思いますが、そのあたりは今後のアップデートを期待して待ちたいと思います。

Cloud Insightのアップデート

その中でも大きな変更点となるのがCloud Insightです。

Cloud InsightsはNetAppやその他のベンダー製品を一括監視できる統合的な監視ソリューションです。

今回のイベントでCloud Insightsあらため「Data Infrastructure Insights」にリブランドされることが発表されました。

もちろん名前が変わるだけでなく新機能も追加されています。

1つ目としてSAN環境専用のトポロジービューが見れるようになりました。

これにより、SANのワークロードにおけるSANファブリックの関係性を可視化し、どこかに問題が発生した場合でも場所の特定が簡単になります。

また、今回のリブランドからNetAppのSTaaSであるKeystoneにData Infrastructure Insightsが追加されることになりました。

これにより、Keystoneの最適化されたストレージ利用状況をData Infrastructure Insightで管理・可視化できるようになり、お客様サービスの質の向上をサポートします。

ランサムウェア対策機能のアップデート

Gagan Gulati氏からは、今やNetAppの代名詞ともいえるランサムウェア対策のアップデートについて発表されました。

ONTAPの自立型ランサムウェア対策機能であるAutonomous Ransomware Protection(以下:ARP)に対し、ランサムウェアの検出や自動Snapshot/アラートに加え、既存のランサムウェアに関するプロファイル情報を自動でアップデートする機能が追加されました。

これまで、ONTAPのバージョンアップ時にしかアップデートされなかったプロファイル情報でしたが、本機能により常に最新の情報を維持できるようになり、リアルタイムにでの検出が重要になるランサムウェア対策における効果的な機能強化となりそうです。

ただし、これまでARPの強みであったインターネット接続不要で利用できるというメリットとのバランスについては検討しながら導入する必要がありそうですね。

また、セキュリティ製品やサービスを評価する製品検査機関であるSE LabsがARP機能を検証し、ランサムウェアに対する誤検知が0だったことが証明され、最高評価である「AAA」に認定されたことも紹介しました。

ARPの新機能については、ONTAP 9.16.1からGA予定となっており、これまでのARPと同様にONTAP Oneのライセンス内で利用できます。

また、BlueXP Ransomeware Protectionにも変化がありました。

これまで同機能はBlueXP内で管理されているストレージリソース(ONTAPやCVOなど)のランサムウェア対策状況を可視化することで、組織内の脆弱性をチェックするようなサポート機能として利用することができました。

今回のアップデートにより、リブランドされたData Infrastructure InsightsがBlueXPに統合され、ランサムウェア攻撃を検出した際のアラート管理やフォレンジック、Snapshotからのリストアなどが実施できるようになりました。

【ランサムウェア検出時の画面】

【アラートの詳細画面】

【フォレンジック画面】

・ファイルアクティビティ

・攻撃を受けたファイルの詳細

【ボリュームのリストア画面】

いわゆる旧Cloud Insightsのランサムウェア対策機能であるStorage Workload SecurityがBlueXPから操作できるように見えますね。

本機能についての金額感や機能詳細については説明されていませんので、本機能については詳細を追ってご報告させていただければと思います。

対談⑤:DreamWorks

本対談では、DreamWorksの最新映画の紹介や、CGアニメーションは膨大なデータを要するため、大規模かつハイパフォーマンスな環境が必須となり、ランサムウェア対策などのセキュリティ機能にも十分投資する必要があるとし、NetAppとの30年におよぶパートナーシップについて強調しました。

NVIDIA DGX SUPERPOD + NetApp AFF

Krish Vitaldevara氏からは、NVIDIAのスーパーコンピューティングインフラストラクチャであるDGX SUPERPODに対し、新たにAFFシリーズのA90を認定するためのプロセスが開始されたことを発表しました。

これまでDGX SUPERPODでサポートされていたNetApp EFシリーズに加え、ONTAPを搭載したエンタープライズストレージが認定されることになれば、パフォーマンスとセキュリティを兼ね備えた協力なシステムをDGXと連携して提供できるようになります。

※現段階で認定がされているわけではありません。

今後の追加情報をお待ちください。

スケールアップ/アウトアーキテクチャのアップデート

これまでのNetAppストレージは、ストレージを拡張するとクラスタとしてグループ化されるものの、ストレージプールであるアグリゲートについては、それぞれの筐体で管理する方式となっていました。

今後、複数筐体でアグリゲートを共有する「DISAGGREGATE STORAGE ARCHITECURE」という構成が検討されていることについて発表がありました。

これにより、ストレージコンピュートリソースと容量を独立して拡張できるようになり、スループットが劇的に向上すると強調しました。

※こちらは構想段階の機能になります。

新機能としてGAされているわけでないことについてご留意ください。

NVIDIA NeMo Retoriverとの連携

NeMo Retrieverは、NVIDIAが提供するAIソフトウェアプラットフォーム「NVIDIA AI Enterprise」に含まれる情報検索サービスです。

生成AIアプリでRAG(検索拡張生成)を実現するための機能を提供するもので、デモではNetAppストレージ内のデータを検索対象にする様子が公開されました。

【データコレクションをNeMo Retoriverへ連携する】

【連携されたデータを元にNeMo Retoriverで条件付き検索をする様子】

これが実現されれば、NetAppのオンプレミス/クラウドストレージとNeMo Retrieverによる生成AIシステムを導入することで、RAGの検索対象としてセキュアかつ耐障害性に優れたエンタープライズストレージの大容量データを活用できますね。

※こちらは構想段階の機能になります。

新機能としてGAされているわけでないことについてご留意ください。

| Keynote Day3 |

最終日となる3日目はNetAppのPresidentであるCésar Cernuda氏とSenior DirectorのHoseb Dermanilian氏が登場し、ゲスト対談が中心となる形で進んでいきます。

対談⑥:NVIDIA

Matt Hull氏は、エンタープライズクラスへAIシステムの導入が普及してくる前までは、大企業がテスト的に小規模でAIシステムを開発することが主流だったとAI導入における流れを説明し、AIシステムの規模が大きくなってきた今だからこそガバナンスやセキュリティが重要になってきたと語りました。

また、前日に発表されたDGX SUPERPOD + NetAppについて、上記のような条件下で大きな力を発揮するとして期待を寄せました。

様々なツールとの連携

ここでは、AIやそれを取り巻く様々なツールとNetAppがどのように連携するのか、実際の画面を見ながら解説をしてくれました。

【Dominoとの連携】

・機械学習のワークフローにNetAppのデータを利用する

【Dremioとの連携】

・オープン型のデータレイクにNetAppのデータを組み込む

【Instaclustrとの連携】

・InstaclustrのPostgreSQL管理とPGVectorを連携し、LLMの精度を向上させる

【OpenShiftとの連携】

・AI/MLプラットフォームにNetAppのデータを連携する

各ツールのために新しくデータ基盤を作るのでなく、既に存在するNetAppからデータを連携することで無駄なステップを踏まずに最速で処理が進められることが分かりますね。

このような形が今NetAppが目指しているものということがあらためて理解できました。

対談⑦:IEO

Annarosa Farina氏は、ヘルスケア業界とAIの相性が良いことに触れ、患者の診断データから今後どのような症状が発生しうるのか予測モデルと立てることができたり、MRIのスキャン時間が三分の一に短縮されたりと、実際の効果を紹介しました。

今回のイベントでは、多くの医療関係者やその事例が紹介されましたね。

どの業界にとっても重要なことはもちろんですが、医療というセキュアでスピードが求められる業界にとっては、やはりセキュリティやガバナンス、パフォーマンスに優れたNetAppのソリューションが最適であると強く感じました。

これからNetApp × AIを提案していくうえでのヒントになるかもしれません。

その後、NetApp SVPのJenni Flinders氏からパートナーアワードの発表があり、長かった3日間のイベントが終わりを迎えました。

ここまで、ものすごい量の発表があったかと思いますがお疲れじゃありませんか?

ちょっとお腹いっぱいだと思いますので、最後に軽いデザートとしてレセプション会場であるFestival Groundの様子もお伝えできればと思います。

Festival Groundではスポンサーブースが立ち並び、ゲームやミニセッションなど、気軽に楽しめるコンテンツが多くありました。

また、NetAppのブースでは最新のストレージや各ストレージのフロントベゼルが展示されており、なかなか壮観な眺めになっていました。

| まとめ |

【SB C&S NetAppプロモーションTwitterアカウント】

NetAppに関するさまざまな情報を公開しています。

皆様フォロー宜しくお願いいたします。

TwitterアプリからはこちらのQRコードもどうぞ。

他のおすすめ記事はこちら

著者紹介

SB C&S株式会社

ICT事業本部 技術本部 技術統括部 第1技術部 2課

河村 龍 - Ryu Kawamura -