こんにちは。SB C&Sの幸田です。

NVIDIA Networkingのご紹介ブログ、第6回はリファレンスアーキテクチャのご紹介です。

リファレンスアーキテクチャとは、特定の機器やシステムを設計・構成する際の、推奨される構造やベストプラクティスを提示するドキュメントを主に指します。

ITの領域においては、サーバー、ネットワーク、ストレージ、ソフトウェアなどをあわせてシステム設計・構築を行う際の、構成のベストプラクティスを表すものがよくリファレンスアーキテクチャとして参照されるかと思います。

今回ご紹介するリファレンスアーキテクチャは、NVIDIA GPUサーバーとNetworking製品、およびストレージによるシステム構成のベストプラクティスを中心としたものです。NVIDIAにて互換性、安定性、そして性能に関する事前検証が行われている構成であるため、安心して、かつ迅速に設計を行うことを可能にします。

複数台のGPUサーバーをクラスタ化する環境で重要となるのは、やはりノード(GPU)間の接続や、ノードとストレージ間の接続のためのネットワークです。この部分を確実に構成するために参考となる情報が豊富に掲載されていますので、ぜひとも目を通していただければと思います。

今回は以下4つの章に分けて、NVIDIAの提供するリファレンスアーキテクチャをいくつかご紹介します。

1. NVIDIA DGX BasePOD

2. NVIDIA DGX SuperPOD

3. NVIDIA Enterprise Reference Architecture

4. その他のリファレンスアーキテクチャ

1. NVIDIA DGX BasePOD

NVIDIA DGX BasePODは、NVIDIAがハードウェア・ソフトウェアともに構成済みで提供しているプラットフォーム製品であるNVIDIA DGX のクラスターを、2ノードから数十ノードまで拡張可能なリファレンスアーキテクチャです。

本記事の公開時点 (2025年10月) で最新のNVIDIA DGX B200 BasePODについては、公式ドキュメントに詳細な情報が掲載されています。

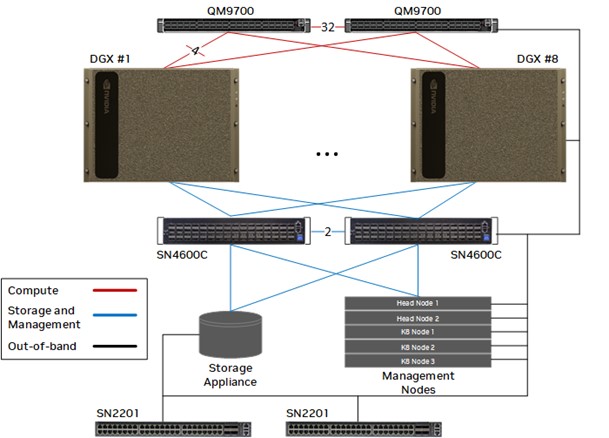

https://docs.nvidia.com/dgx-basepod/reference-architecture-infrastructure-foundation-enterprise-ai/latest/reference-architectures.html より

推奨されるスイッチのモデル、ケーブルの本数までもがガイドされており、迅速に基本設計を行うことが可能です。

2. DGX SuperPOD

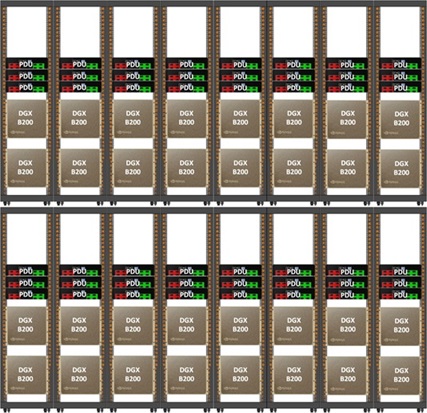

DGX 32台で構成されるスケーラブルユニット (SU) 単位で導入できる大規模クラスターが、NVIDIA DGX SuperPODです。

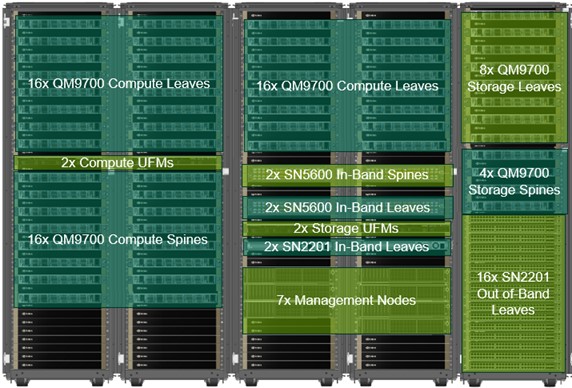

https://docs.nvidia.com/dgx-superpod/reference-architecture-scalable-infrastructure-b200/latest/dgx-superpod-architecture.html より

https://docs.nvidia.com/dgx-superpod/reference-architecture-scalable-infrastructure-b200/latest/dgx-superpod-architecture.html より

SuperPODを導入する際は、NVIDIAによる導入に際しての各種プロフェッショナルサービスが提供されますので、詳細な設計はその中で行っていただくこととなりますが、こちらの公式ドキュメント(DGX B200版)をご覧いただくことで正確な規模感や構成要素を把握いただくことが可能です。

なおSuperPODは、より新しいDGX B300を採用したものや、CPUとGPUを密結合させた Grace Blackwell を搭載した DGX GB200 によって構成されるものについても、一部のリファレンスアーキテクチャが公式ドキュメントとして公開されています。

3. NVIDIA Enterprise Reference Architecture

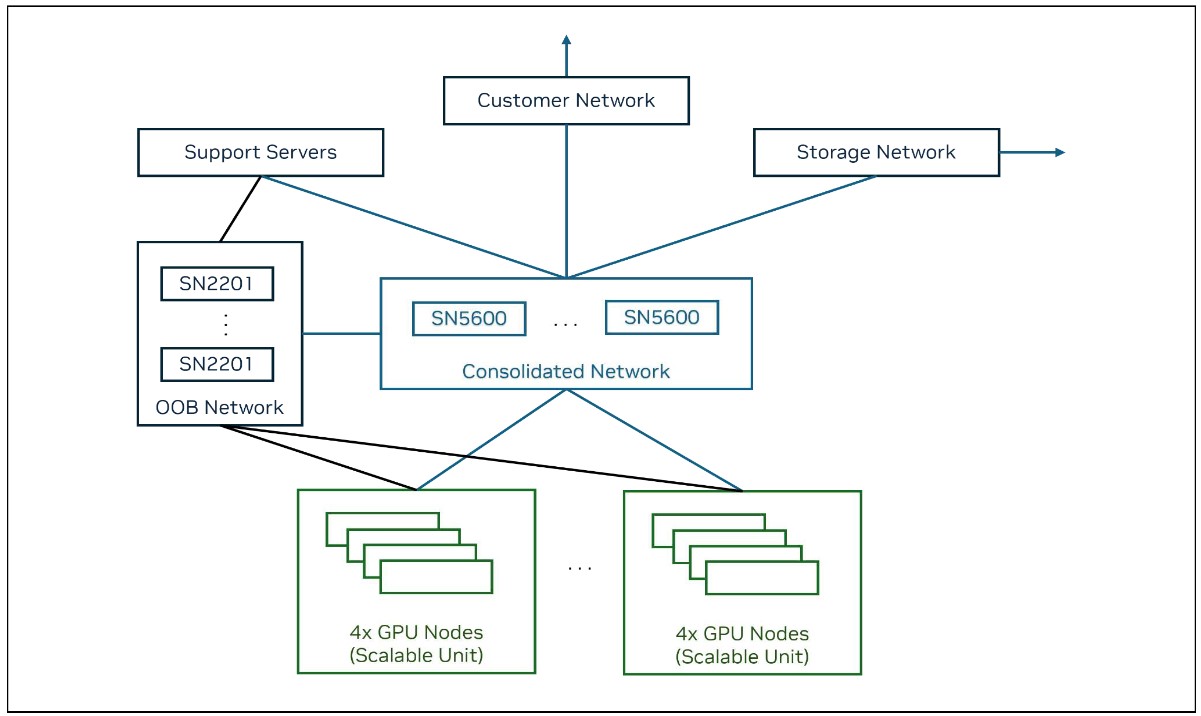

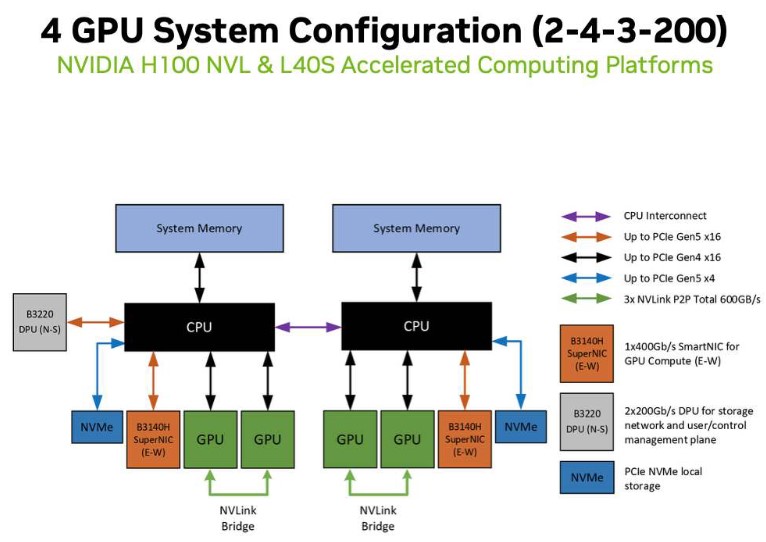

NVIDIA Enterprise Reference Architectureは、32~256基のGPU、つまりGPUを8基搭載するサーバーであれば4~32台の構成について、サーバーの構成やネットワークトポロジー、スイッチング、ストレージ接続、および管理プレーンの構成までがガイドされています。

なお、サーバー1台あたりのGPU搭載数を2または4とする構成についてもガイドされており、必ずしもGPU8基を搭載するサーバーを選択しなければならないわけではありません。

https://resources.nvidia.com/en-us-certified-systems/collection-9563de54 より

https://resources.nvidia.com/en-us-certified-systems/collection-9563de54 より

このリファレンスアーキテクチャにおいては、サーバー1台の構成について、GPUだけでなくCPU, ネットワークアダプタ数、GPU1基あたりのGPU間接続の帯域幅についてのリファレンスも分かりやすく提示されており、それぞれの数量を並べた C-G-N-B を呼称として用いています。

C : CPUソケット数

G : GPU数

N : ネットワークアダプタ数

B : GPU1基あたりのGPU間接続の帯域幅

例えば、CPUが2ソケット、GPUが8基、ネットワークアダプタが5基、GPUあたりの帯域幅が200GbE の場合、2-8-5-200 という呼称が付与され、ドキュメント内の説明においてその呼称が用いられています。CPUが2, GPUが4, ネットワークアダプタが3, 帯域幅が200GbEであれば、2-4-3-200 です。

2025年10月現在では、2-8-9-400, 2-2-3-400, 2-8-5-200, 2-4-3-200 の4パターンが掲載されています。GPUの種別についても、最新の RTX PRO 6000 Blackwell Server Edition に加え、H200 NVL, L40S など複数パターンが含まれています。

4. その他のリファレンスアーキテクチャ

以下はご参考までに、NVIDIAプロダクトを用いたシステムの構成に役立つガイドをご紹介します。

Networkingには直接関係のないもの、もしくはシステムインテグレーター様やユーザー様が直接ご利用する想定ではないものですが、有用な情報ですのでご参照いただけますと幸いです。

NVIDIA-Certified Systems Configuration Guide

NVIDIAの認定を受けたプロダクト、特にGPUサーバー(単体)について、サイジングを行う際のスタートガイドとして参照いただくことができるドキュメントがNVIDIA-Certified Systems Configuration Guideです。

このガイドが、GPUにあわせたCPU, メモリ, ネットワーク、ローカルストレージなどのサイジングにおける最初の足掛かりとなります。

NVIDIA AI Enterprise Software Reference Architecture

NVIDIAのGPUサーバーを利用する多くのケースで導入されるソフトウェアプラットフォームがNVIDIA AI Enterpriseです。

導入いただくことで、GPUサーバーおよびクラスタの環境構築、運用管理機構のセットアップ、そしてその上でのモデル開発・活用、さらにはアプリケーション開発を、大幅に省力化することが可能です。

このAI Enterpriseに含まれる各種ソフトウェアを適切にデプロイするための構成がガイドされているのがNVIDIA AI Enterprise Software Reference Architectureで、シングルテナントでの利用を前提とし、ソフトウェアとハードウェアに依存しないように設計されています。

NVIDIA AI Data Platform for Enterprise

こちらは少し毛色が異なるリファレンスアーキテクチャで、ストレージベンダーがBlackwell GPU、BlueField-3 DPU、Spectrum-X Ethernet ネットワーク、そして NVIDIA AI Enterprise ソフトウェアを用いたデータプラットフォームを構成する際に参照できるよう提供されるものです。

概要については、紹介ページ、発表時のブログ記事、および各ストレージベンダーのAI Data Platform for Enterpriseへの取り組みに関する記事をご参照ください。詳細にお知りになりたい場合は、ストレージベンダーの方からNVIDIAへご連絡いただくことが必要です。

なおシステムインテグレーター様やユーザー様は、このリファレンスアーキテクチャに従って構成され、ストレージベンダーから提供されるデータプラットフォーム製品を導入することが可能です。

以上、NVIDIAのリファレンスアーキテクチャのご紹介でした。

実際の導入案件における機器選定・設計の際はもちろん、AI基盤がどのような構成をとるものなのかの全体感を把握していただくためにも非常に有用な情報ですので、ぜひともお役に立てていただければと思います。

これで本連載は終了となりますが、弊社では今後もNVIDIAプロダクトを中心としたAIインフラに関する情報発信を積極的に行っていく予定ですので、ぜひともご期待いただきたく願います。

なおSB C&SではNVIDIA Networking製品に加え、NVIDIA GPU搭載サーバー、およびAI基盤で人気の高い各種ストレージについてもお取扱いをしております。

サーバー・ネットワーク・ストレージすべて含めたトータルのシステム提案が可能ですので、ぜひ「お問い合わせ」ページより気軽にお声がけをいただければと存じます。

著者紹介

SB C&S株式会社

ICT事業本部 技術本部 技術統括部 第2技術部 1課

幸田 章 - Akira Koda -

NVIDIA製品を中心としたコンピューティング(グラフィックス, AI/HPC)とネットワーキング、VDI を含む仮想化、クラウド等のプリセールス・エンジニア業務に従事。

VMware vExpert 2015-2022