こんにちは。SB C&Sの湯村です。今回の「基礎から学ぶ!vSAN 7.0 検証環境構築」シリーズ第2回は、「vSANクラスターの拡張」です。前回の記事で作成したvSANクラスターに、新しくESXiホストを追加する手順をご紹介します。

1. vSANの拡張性

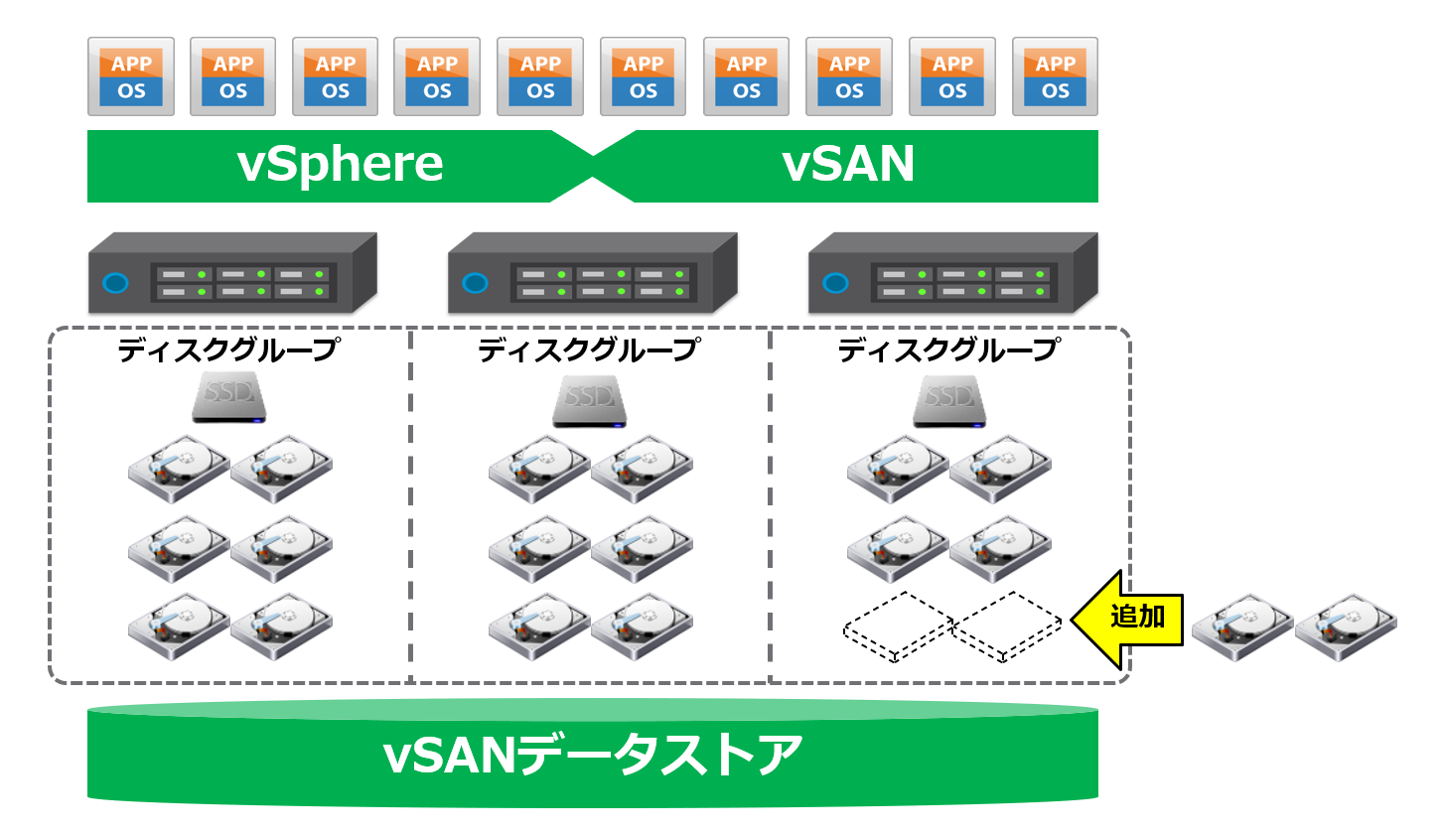

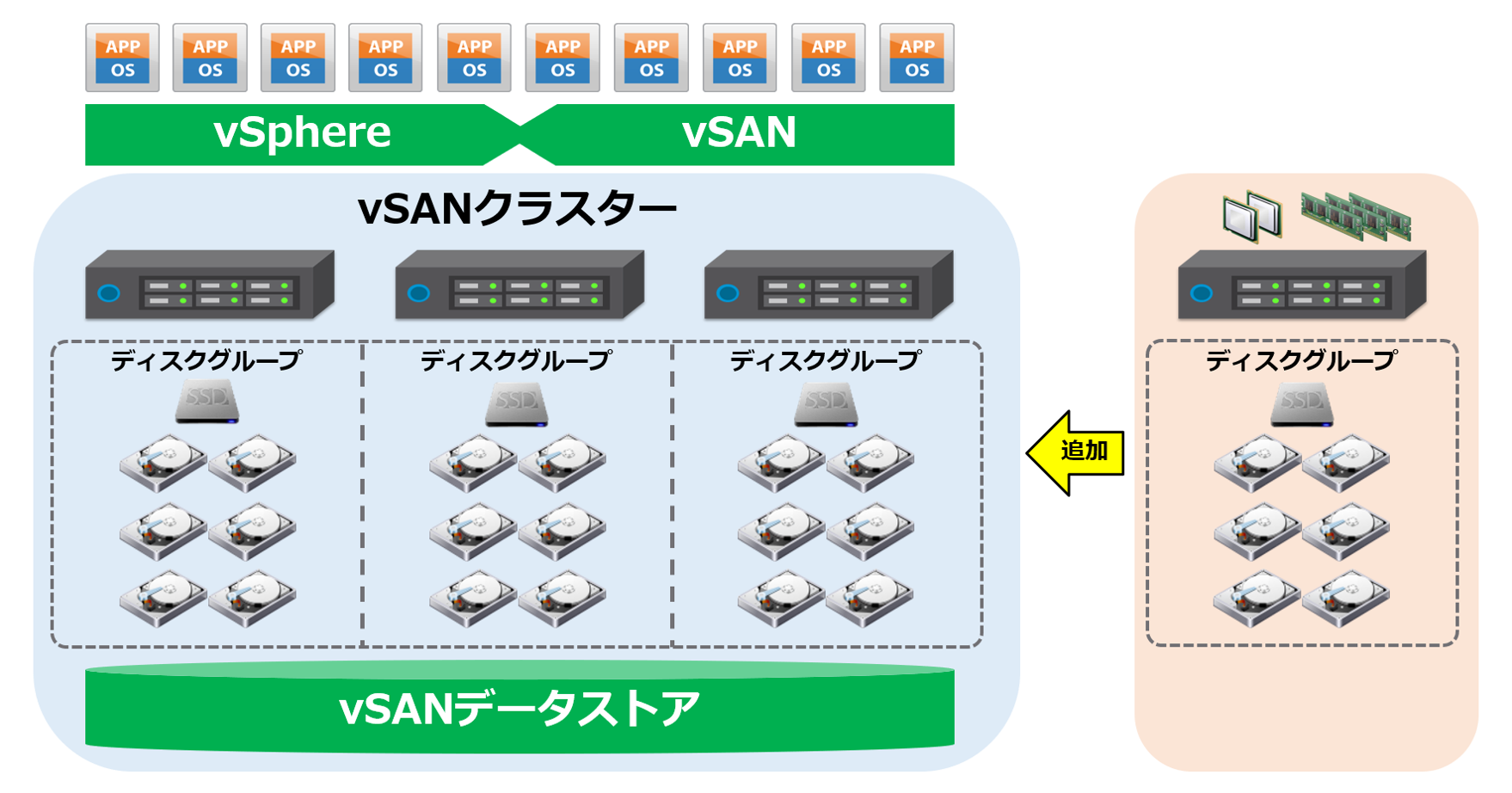

vSANはデータストアを柔軟に拡張できるというメリットがあります。柔軟な拡張というのは、スケールアップやスケールアウトを容易に行えるということです。

スケールアップは、ディスクを追加することでストレージ容量を拡張させる方法です。たとえば下図のように、既存のディスクグループへキャパシティディスクを追加するだけでストレージ容量を拡張することができます。

また、スケールアウトは、下図のように新しいホストを既存のvSANクラスターに追加することでストレージ容量を拡張します。スケールアウトは、ストレージ容量だけでなくCPUやメモリ等の物理リソースも拡張されるため、vSANのパフォーマンスを向上させることができます。

このように、目的に合わせて柔軟に拡張できるのがvSANの特徴です。

2. 使用する環境

今回使用した環境は以下の通りです。以前の「基礎から学ぶ!vSphere 7.0 検証環境構築」シリーズで構築した環境をベースにしていますが、vSANにあわせてESXiホストのハードウェア構成を変更しています。

- ハードウェア:Nested ESXiとして作成した仮想マシン3台

※今回の検証環境ではvSANクラスターを構成するために、各仮想マシンにvSAN用のディスク容量を追加しています。詳しくは以下の環境情報をご覧ください。 - ソフトウェア:VMware ESXi 7.0 Update 3c / vCenter Server Appliance 7.0 Update 3c

※「基礎から学ぶ!vSphere 7.0 検証環境構築」で利用していたiSCSIストレージは不要になります。

【参考】https://kb.vmware.com/s/article/86398

また、今回の環境では、以下の情報を使用しています。

| コンポーネント | ホスト名 | IPアドレス | ディスク追加 |

|---|---|---|---|

| ESXi-A1 | esxi-a1.demo.local | 192.168.255.10/24 | キャッシュディスク:30GB×1 キャパシティディスク:300GB×2 |

| ESXi-A2 | esxi-a2.demo.local | 192.168.255.20/24 | キャッシュディスク:30GB×1 キャパシティディスク:300GB×2 |

| ESXi-A3 | esxi-a3.demo.local | 192.168.255.30/24 | キャッシュディスク:30GB×1 キャパシティディスク:300GB×2 |

| ESXi-A4 (追加用ホスト) |

esxi-a4.demo.local | 192.168.255.40/24 | キャッシュディスク:30GB×1 キャパシティディスク:300GB×2 |

| vCSA | vc-a1.demo.local | 192.168.255.100/24 | - |

下図の赤枠部分を構築していきます。

3. vSANクラスターの拡張

vSANクラスターに新しいホスト(esxi-a4.demo.local)を追加します。追加する際の注意点としては、「VMware Compatibility Guide」に追加するホストのリソースが記載されていることを確認してください。今回は、以下のステップに従ってホストを追加します。

① ホスト追加前のvSANクラスターの合計リソースを確認します。

② ホストを追加します。※メンテナンスモードのまま追加します。

③ Skyline健全性で出ているアラートが正常であることを確認します。

④ 追加したホストのネットワーク設定を行います。

⑤ 追加したホストのディスクグループを作成します。

⑥ メンテナンスモードを解除し、vSANクラスターの合計リソースを確認します。

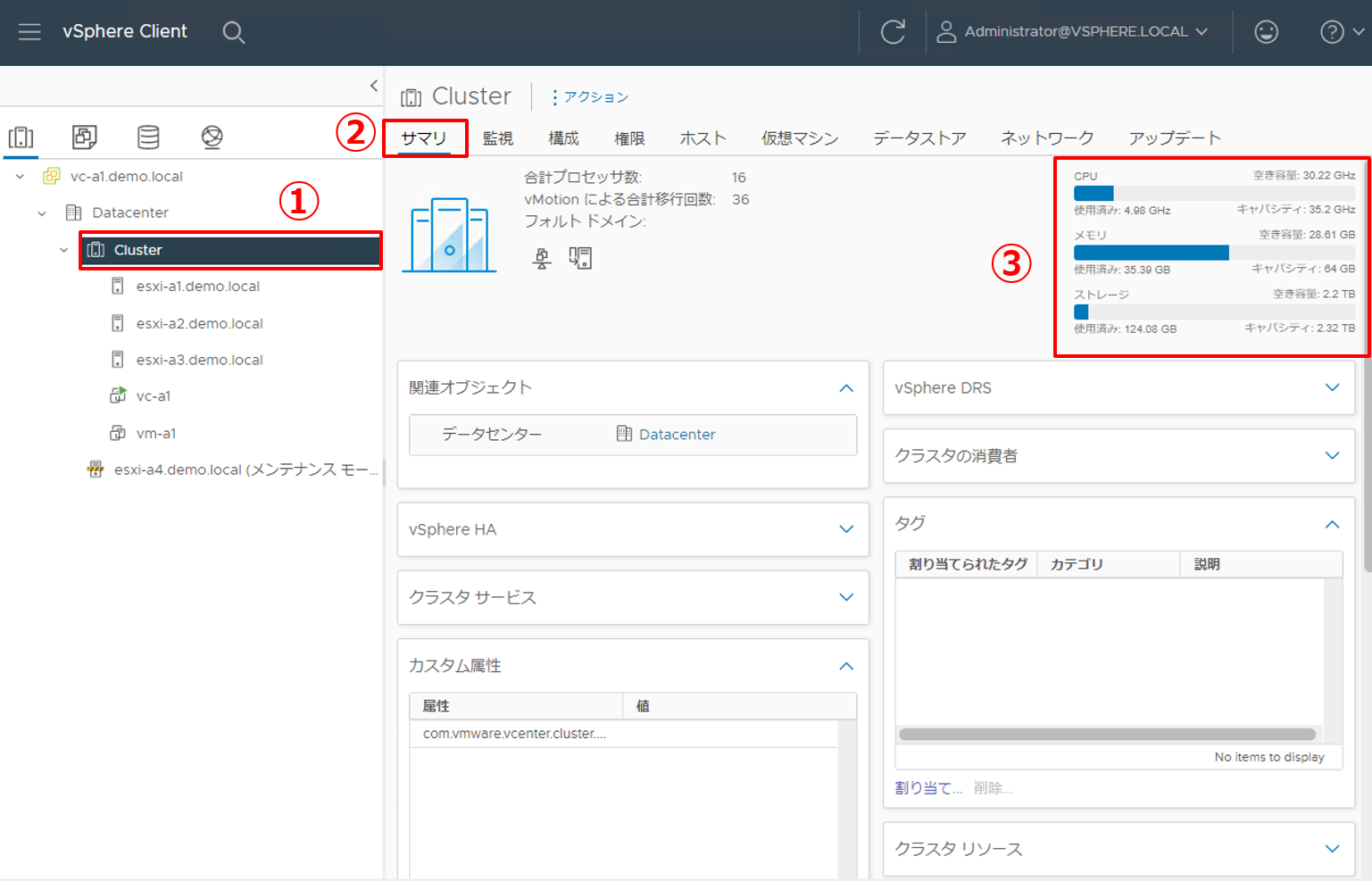

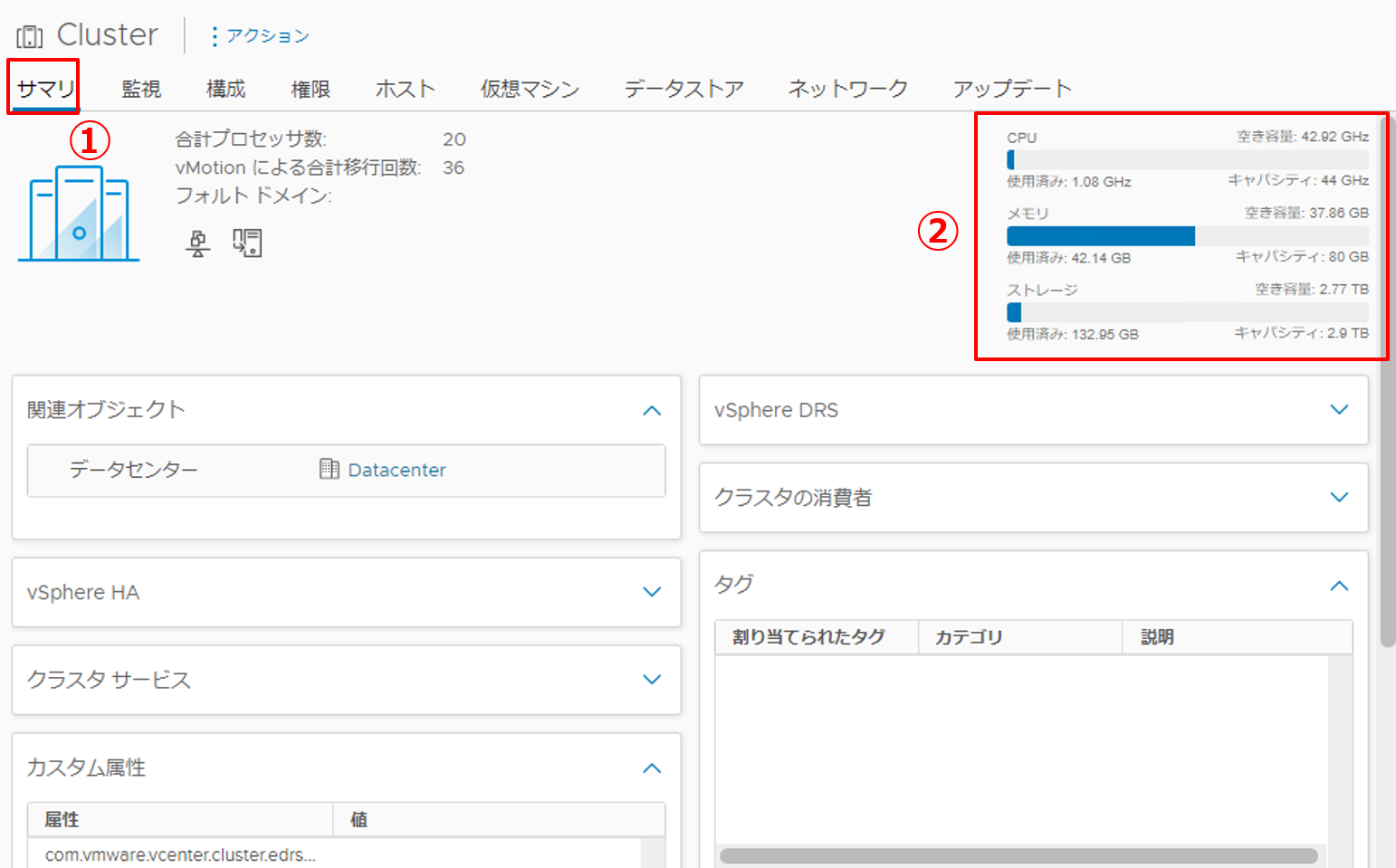

3.1 ホスト追加前の合計リソース確認(①)

ホスト追加前のvSANクラスターの合計リソースを確認します。

|

1. vSphere Clientにログインし、拡張前のリソース合計容量を確認します。

|

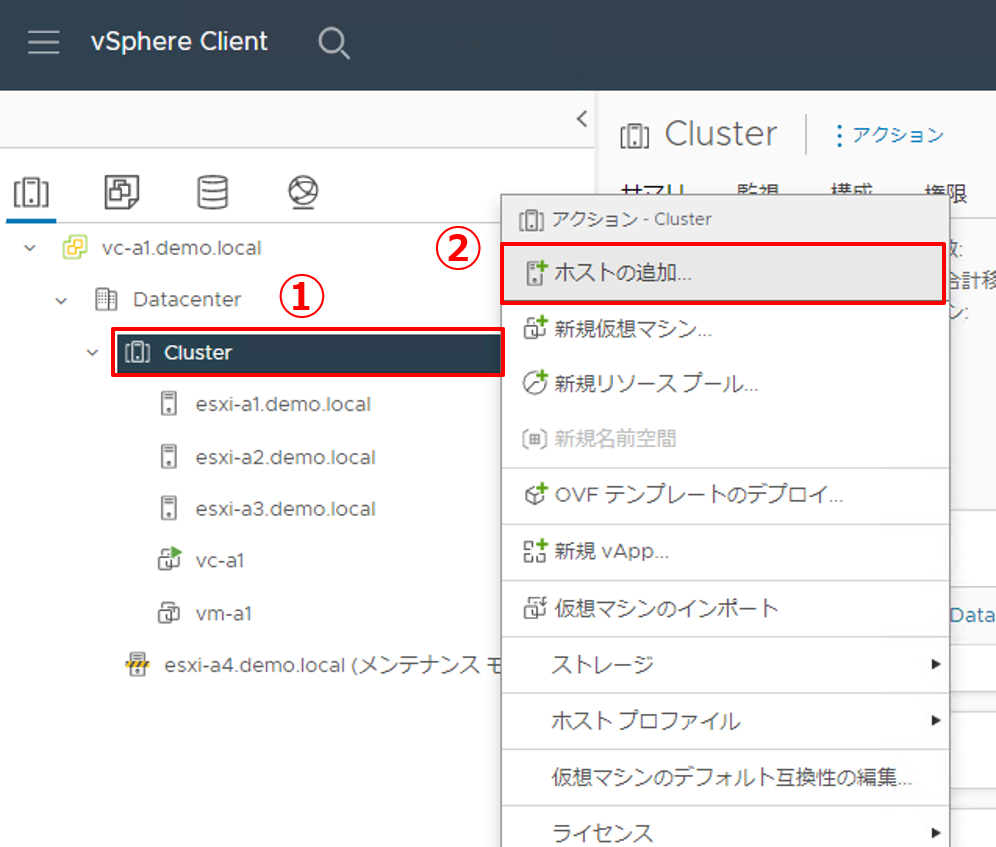

3.2 ホストの追加(②)

vSANクラスターにホストを追加します。

|

1. 新しいESXiホスト(esxi-a4)をクラスターに追加します。

|

|

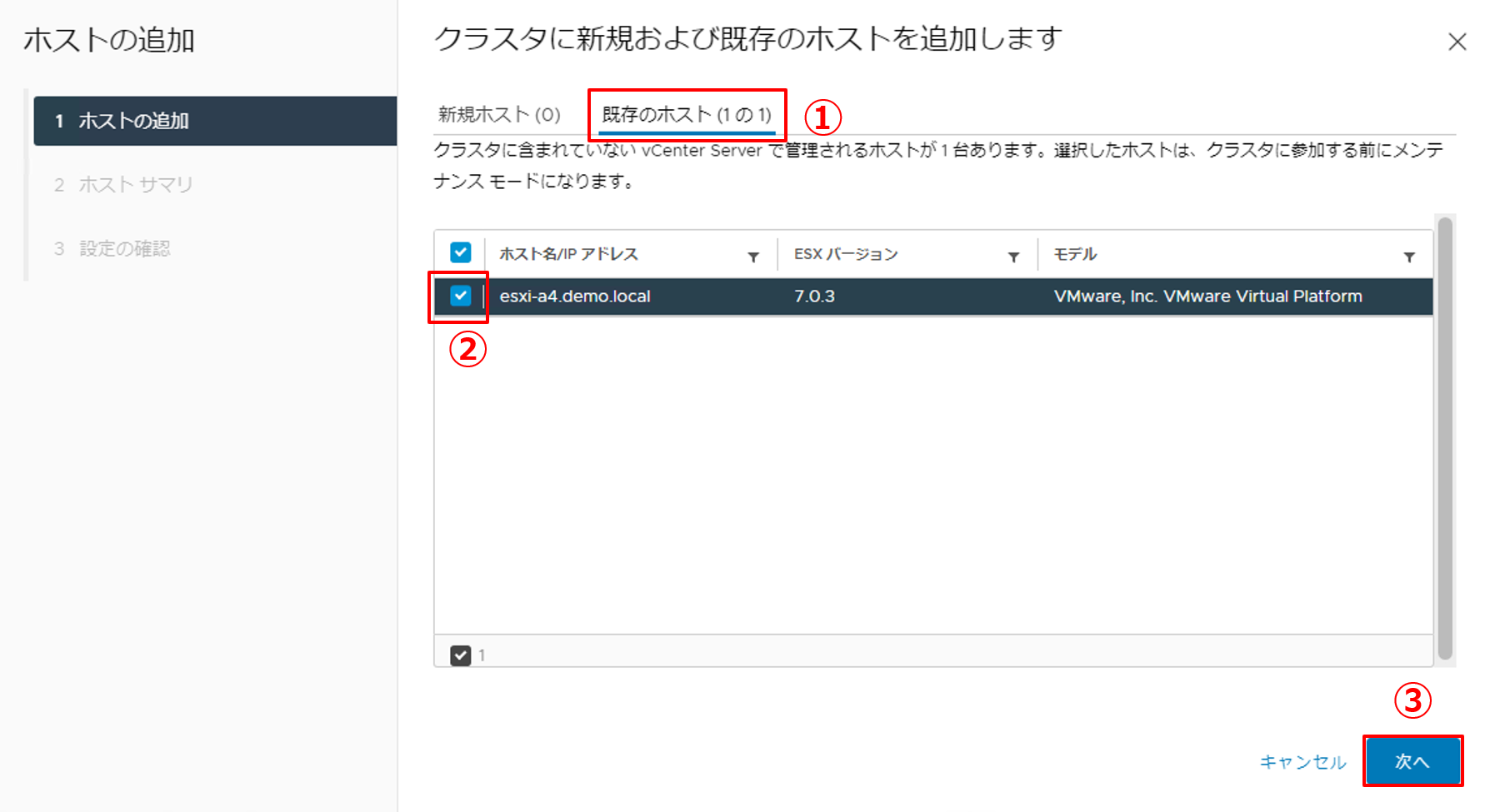

2. ウィザードに従ってホストの追加を行います。

|

|

3. [次へ] をクリックします。 |

|

4. [完了] をクリックします。 |

|

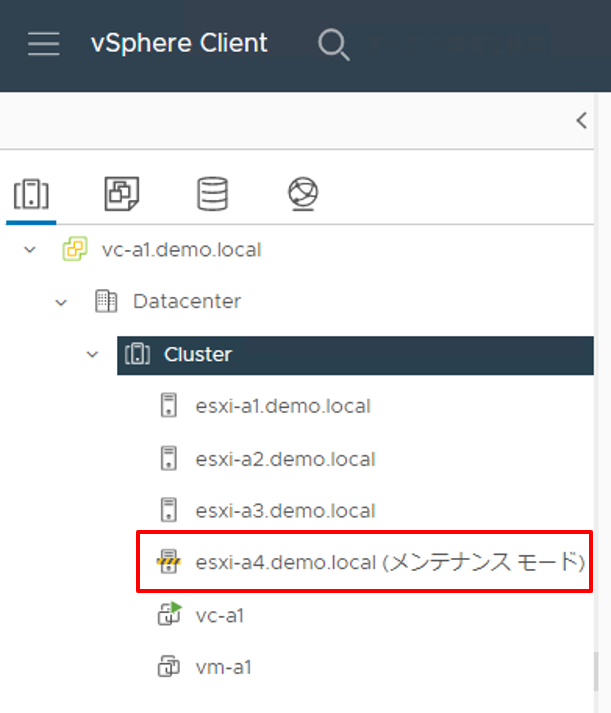

5. 左ペインに [esxi-a4.demo.local] が追加されていることを確認します。 |

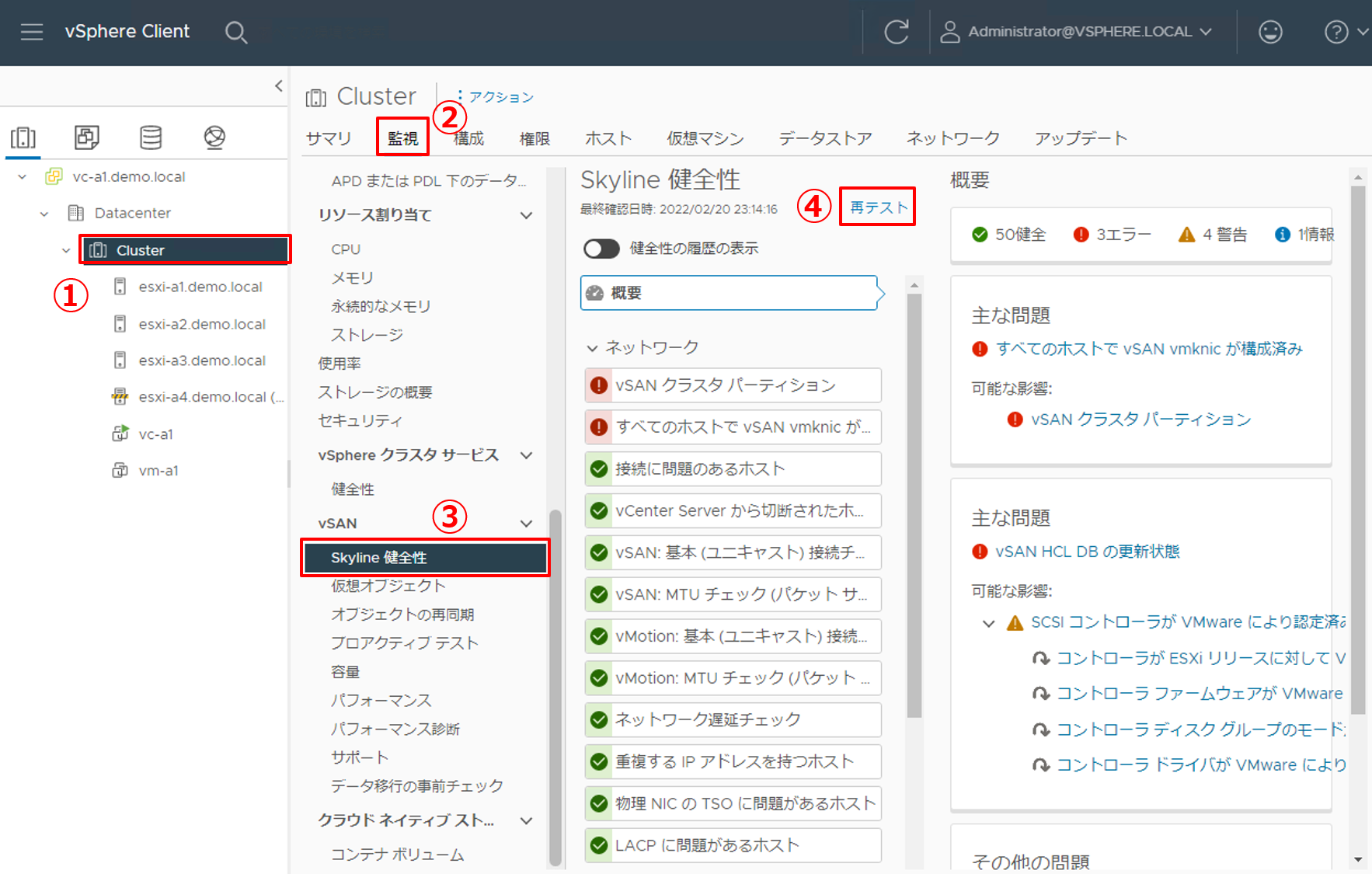

3.3 Skyline健全性の確認(③)

Skyline健全性で出ているアラートが正常であることを確認します。

|

1. Skyline健全性を確認します。

|

|

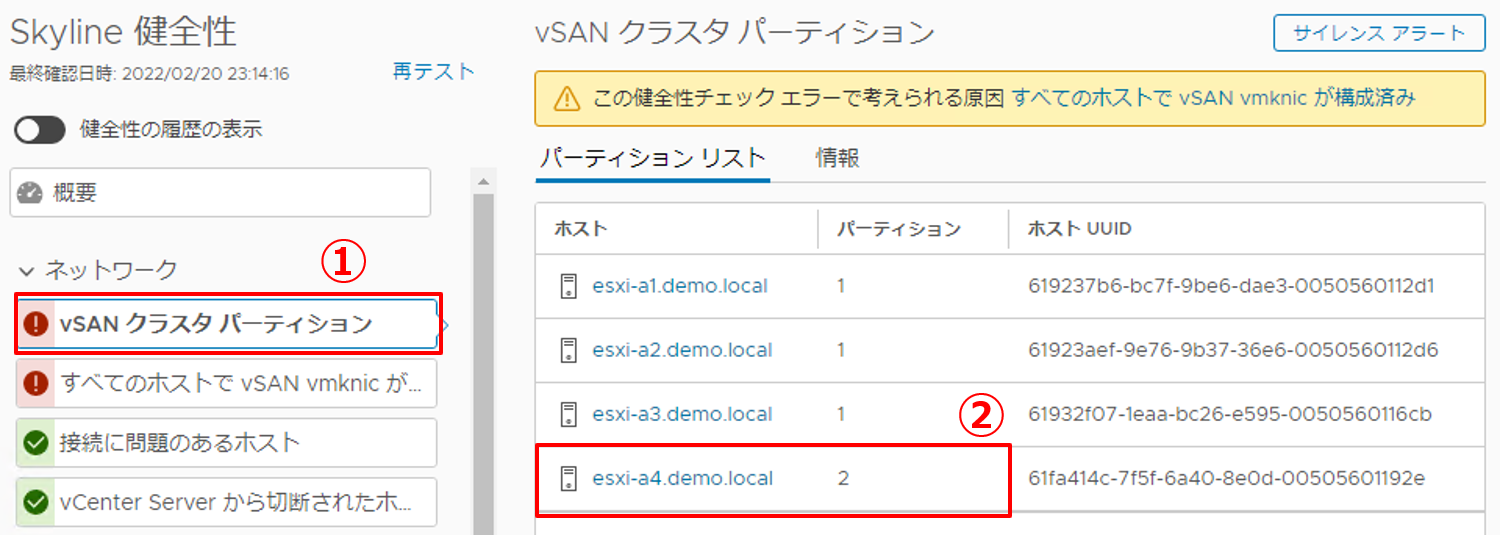

2. [vSAN クラスタ パーティション] のアラートをクリックし、新しく追加したホスト [esxi-a4.demo.local] の [パーティション番号] が既存ホストのパーティション番号と異なることを確認します。 |

|

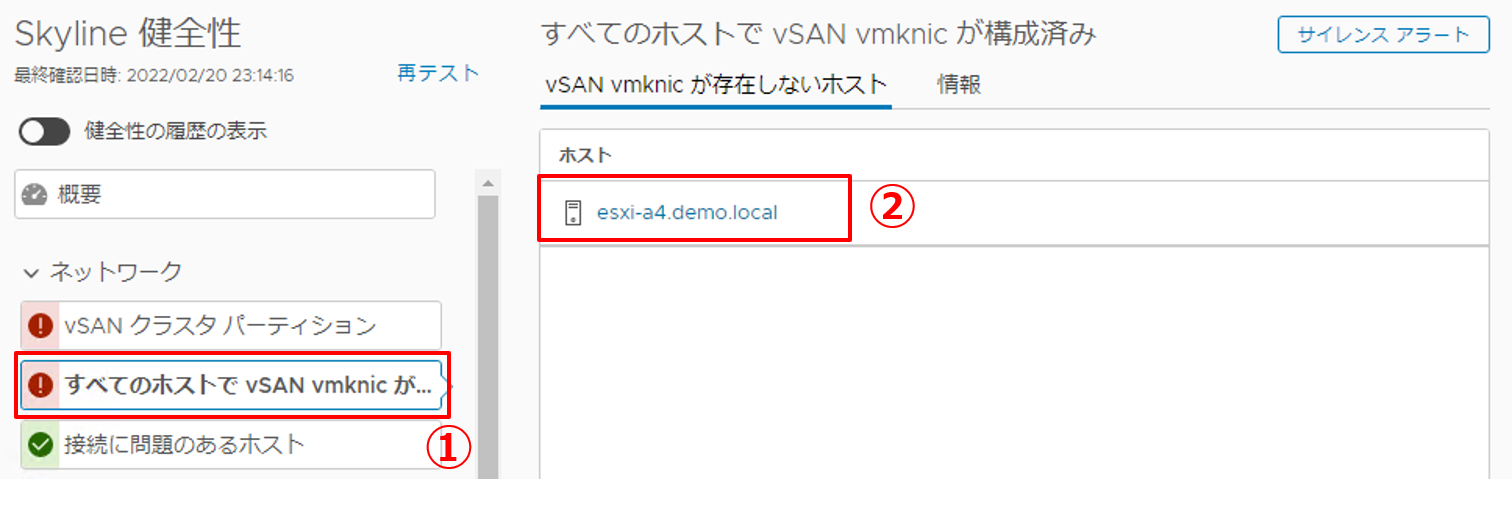

3. [すべてのホストで vSAN vmknic が構成済み] をクリックし、vSAN vmknicが存在しないホストに [esxi-a4.demo.local] が表示されていることを確認します。

|

3.4 ネットワークの設定(④)

追加したホストは元々スタンドアロンであったため、標準仮想スイッチでネットワークが構成されています。今回の検証環境では、分散仮想スイッチにvSANトラフィックを転送させるため、標準仮想スイッチから分散仮想スイッチへネットワークを移行する手順をご紹介します。

分散仮想スイッチについては「基礎から学ぶ!vSphere 7.0 検証環境構築 第5回 ネットワークの設定(分散仮想スイッチ)」で詳しく紹介されていますので、おさらいしたい方は是非ご覧ください。

|

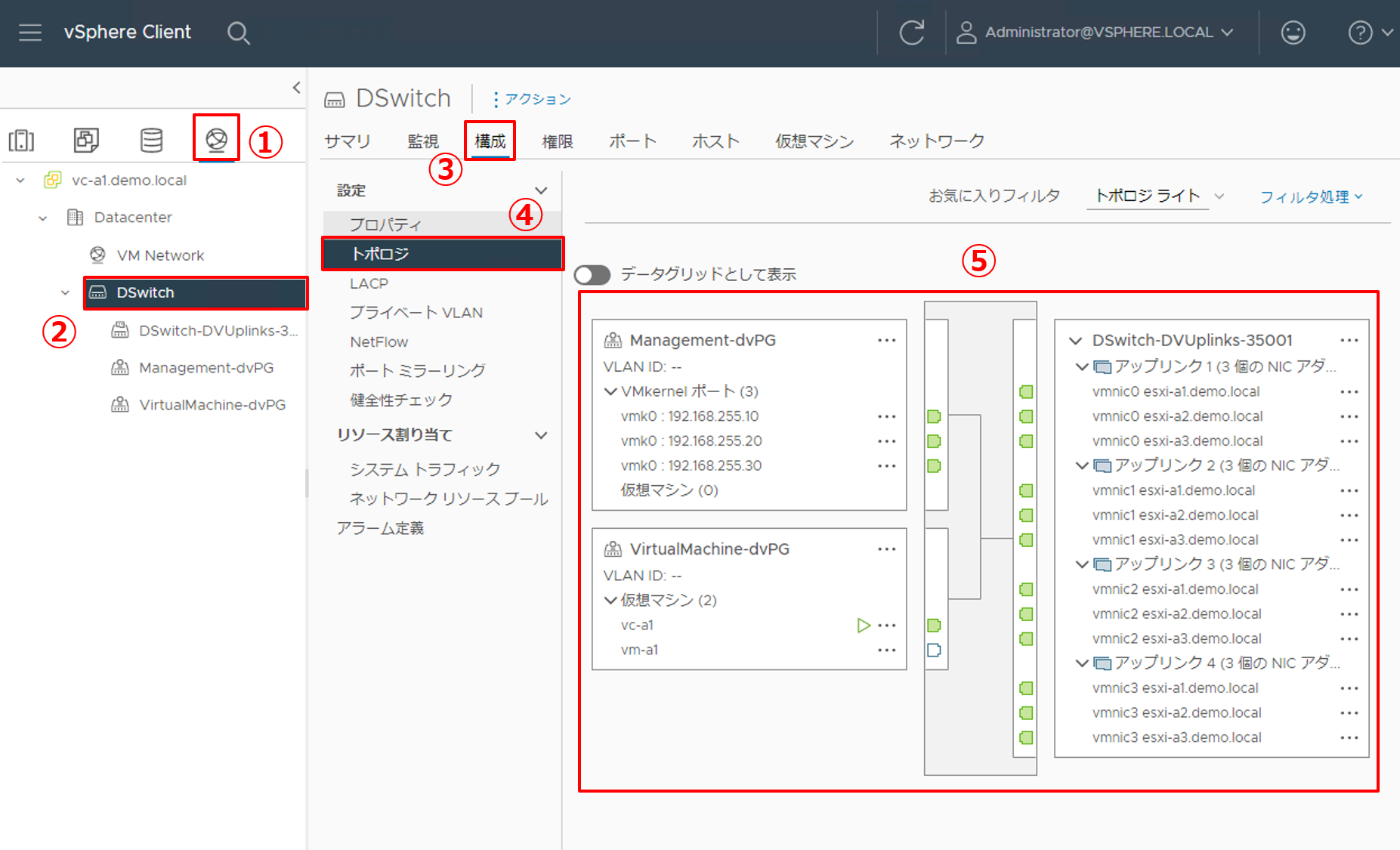

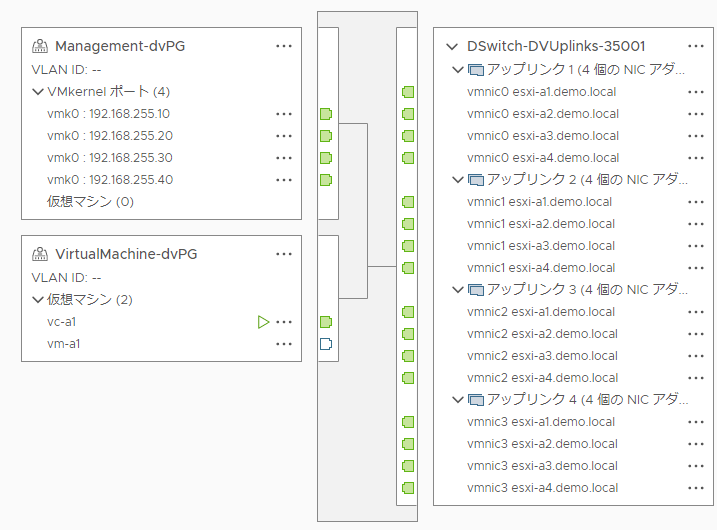

1. 現状の分散仮想スイッチの設定を確認します。

|

|

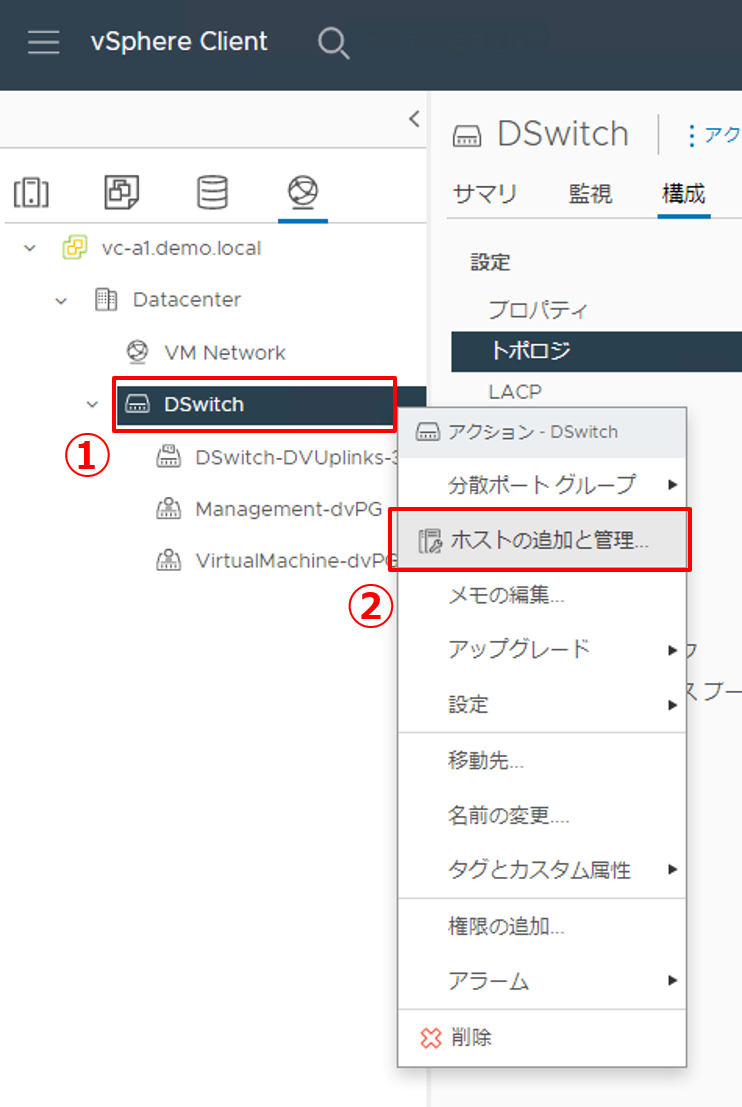

2. 分散仮想スイッチにESXiホストを追加します。

|

|

3. タスクを選択します。

|

|

4. ESXiホストを選択します。

|

|

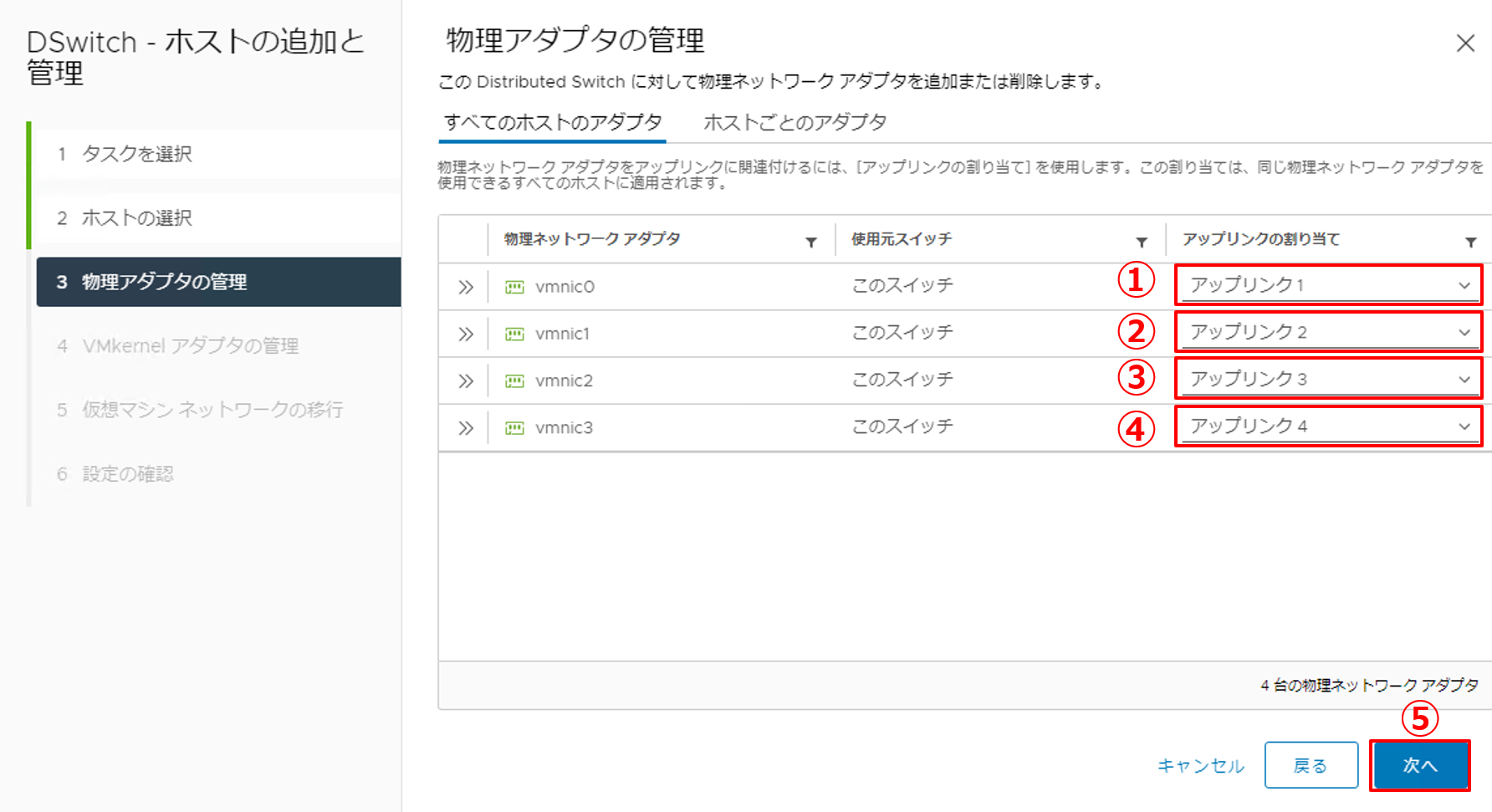

5. 物理アダプタ(物理NIC)にアップリンクを割り当てます。

|

|

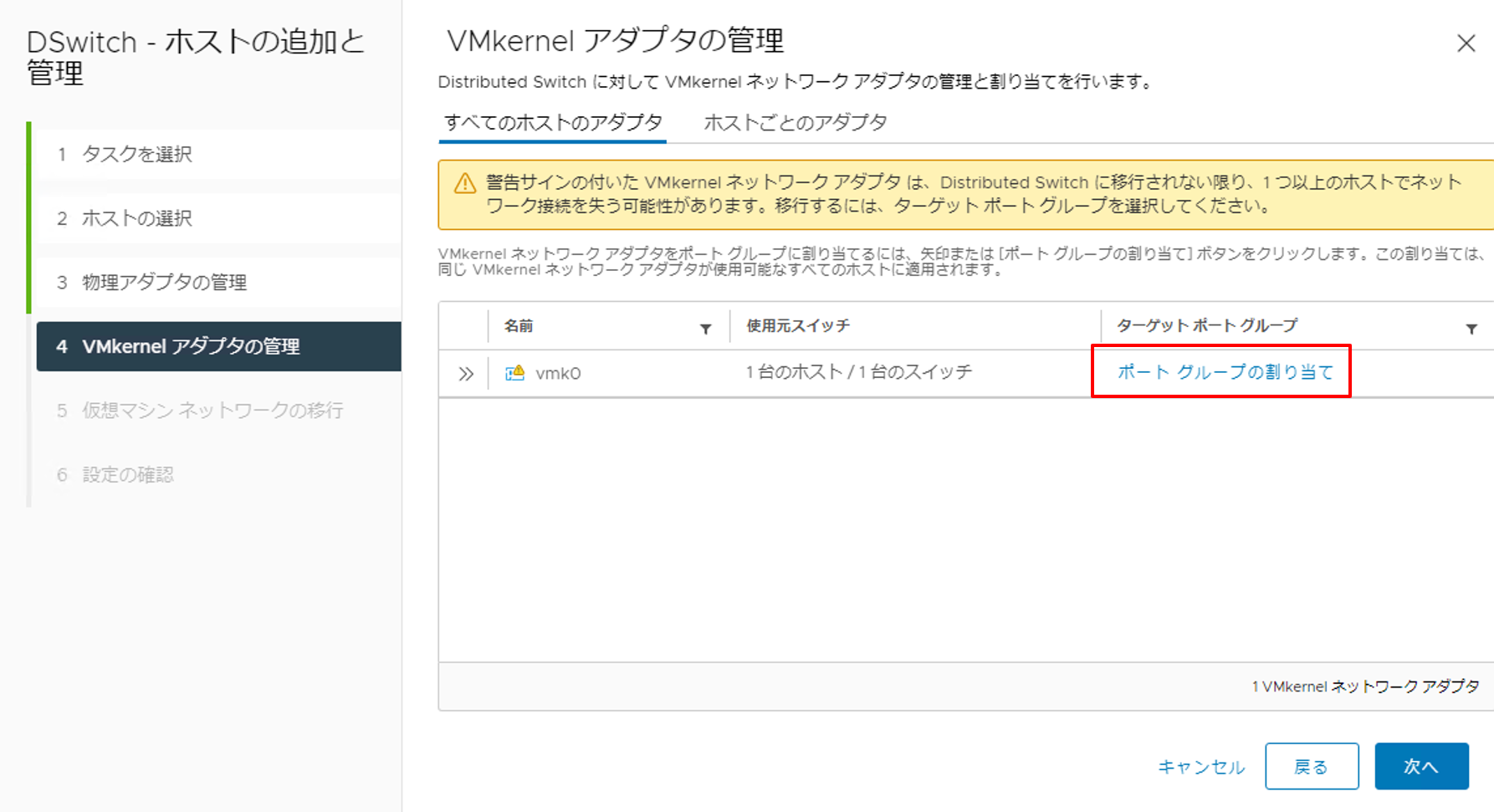

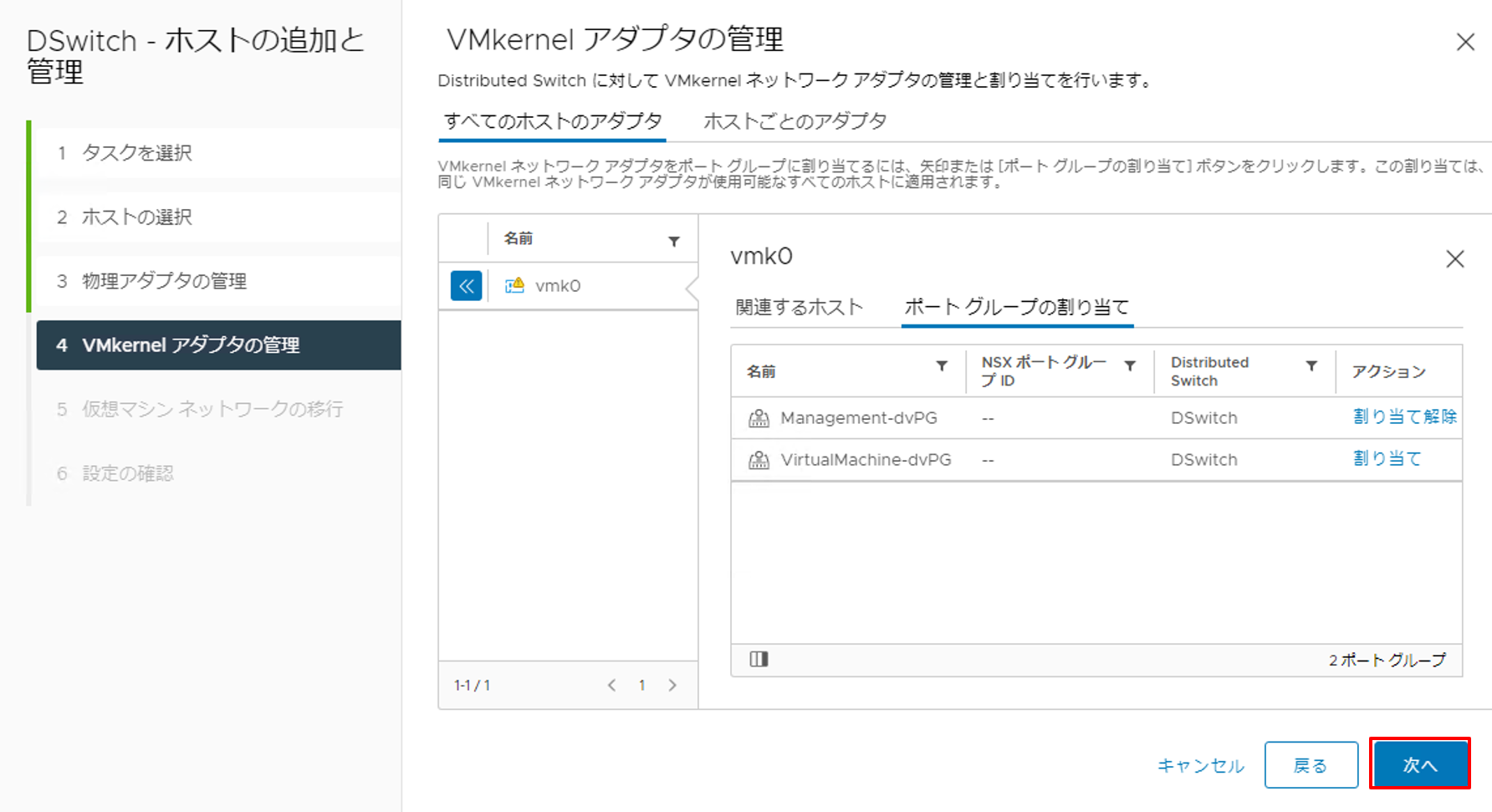

6. VMkernel アダプタの管理で、vmk0の [ポート グループの割り当て] をクリックします。 |

|

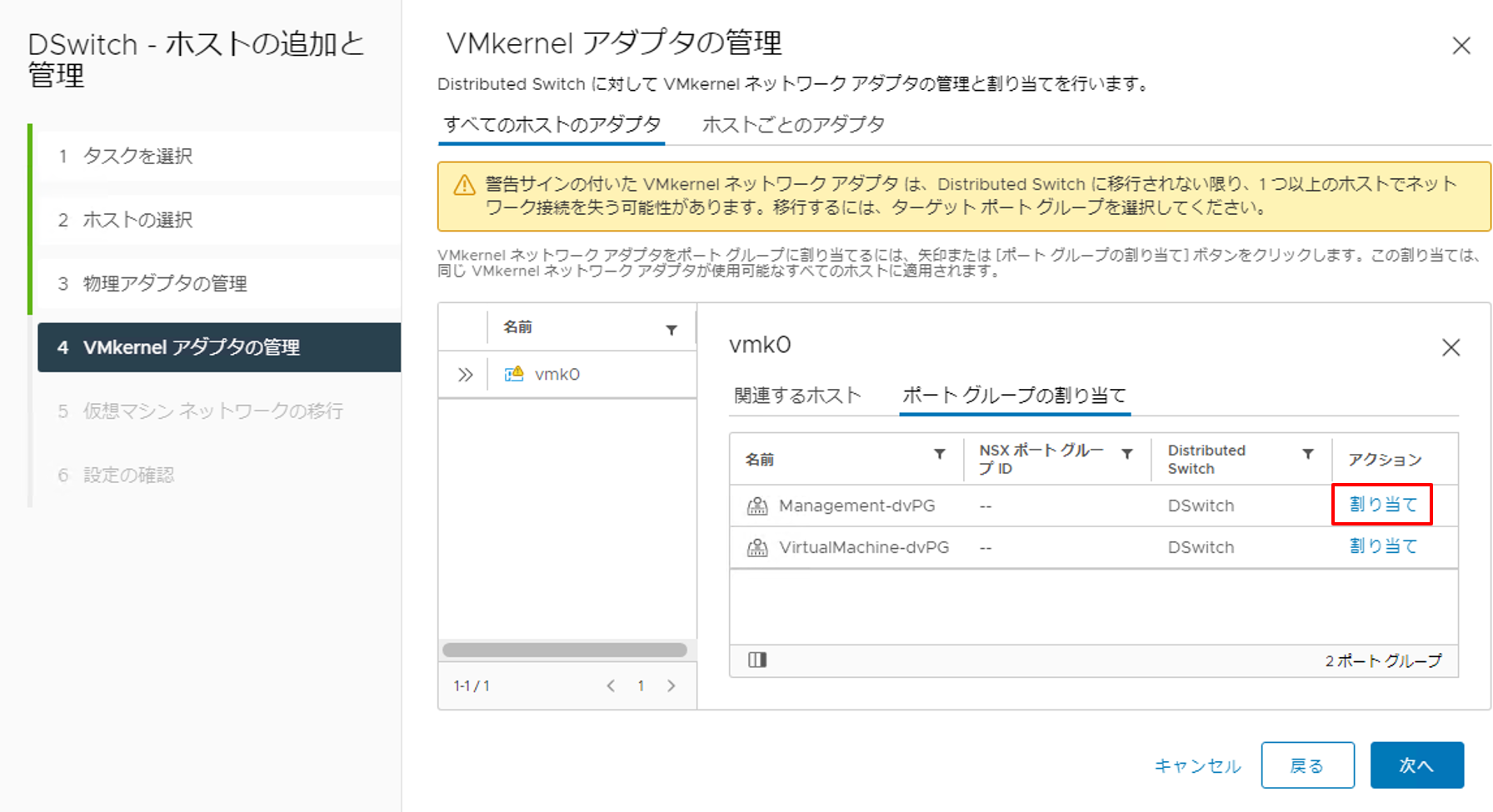

7. Management-dvPGの [割り当て] をクリックします。 |

|

8. [次へ] をクリックします。 |

|

9. [次へ] をクリックします。 |

|

10. 設定内容を確認し、[完了] をクリックします。 |

|

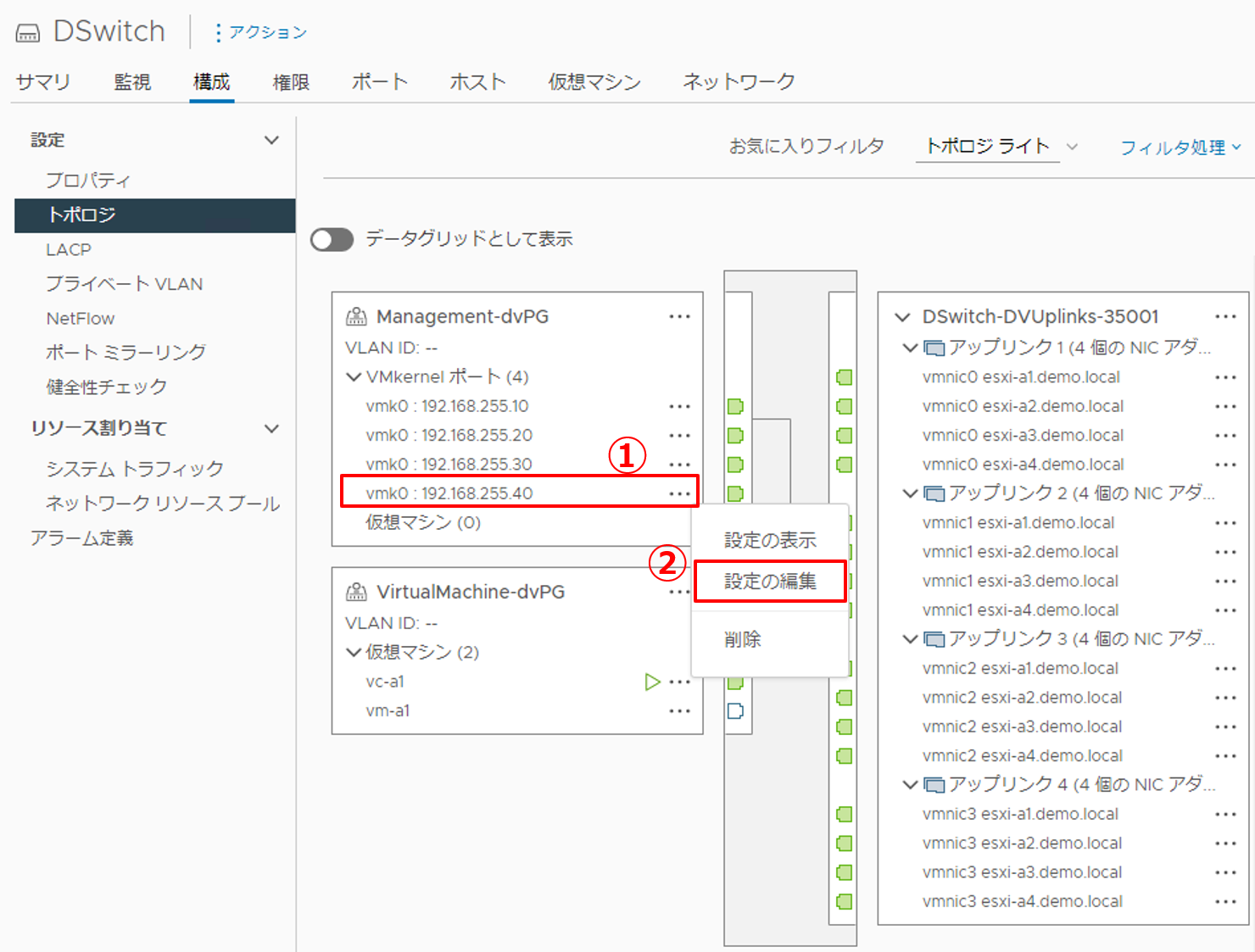

11. トポロジを確認し、ここまでの設定が反映されていることを確認しましょう。 |

|

12. VMkernelポートの設定を編集します。

|

|

13. vmk0にvSANサービスを付与します。

|

3.5 ディスクグループの作成(⑤)

追加したESXiホストに対してディスクグループを作成します。今回は既存のESXiホストと同様の構成にするため、以下の構成でディスクグループを作成します。

- キャッシュディスク:30GB × 1本

- キャパシティディスク:300GB × 2本

|

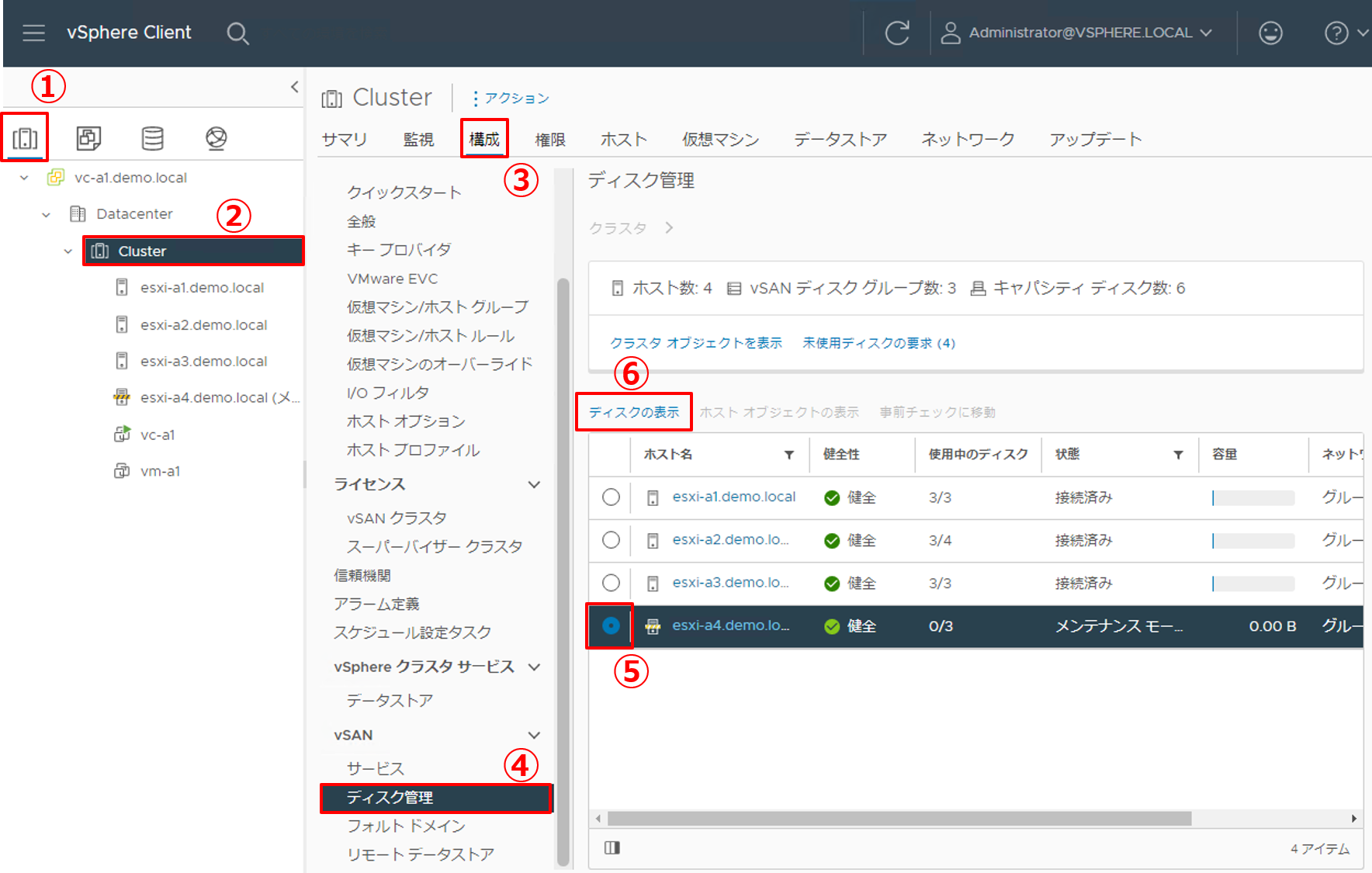

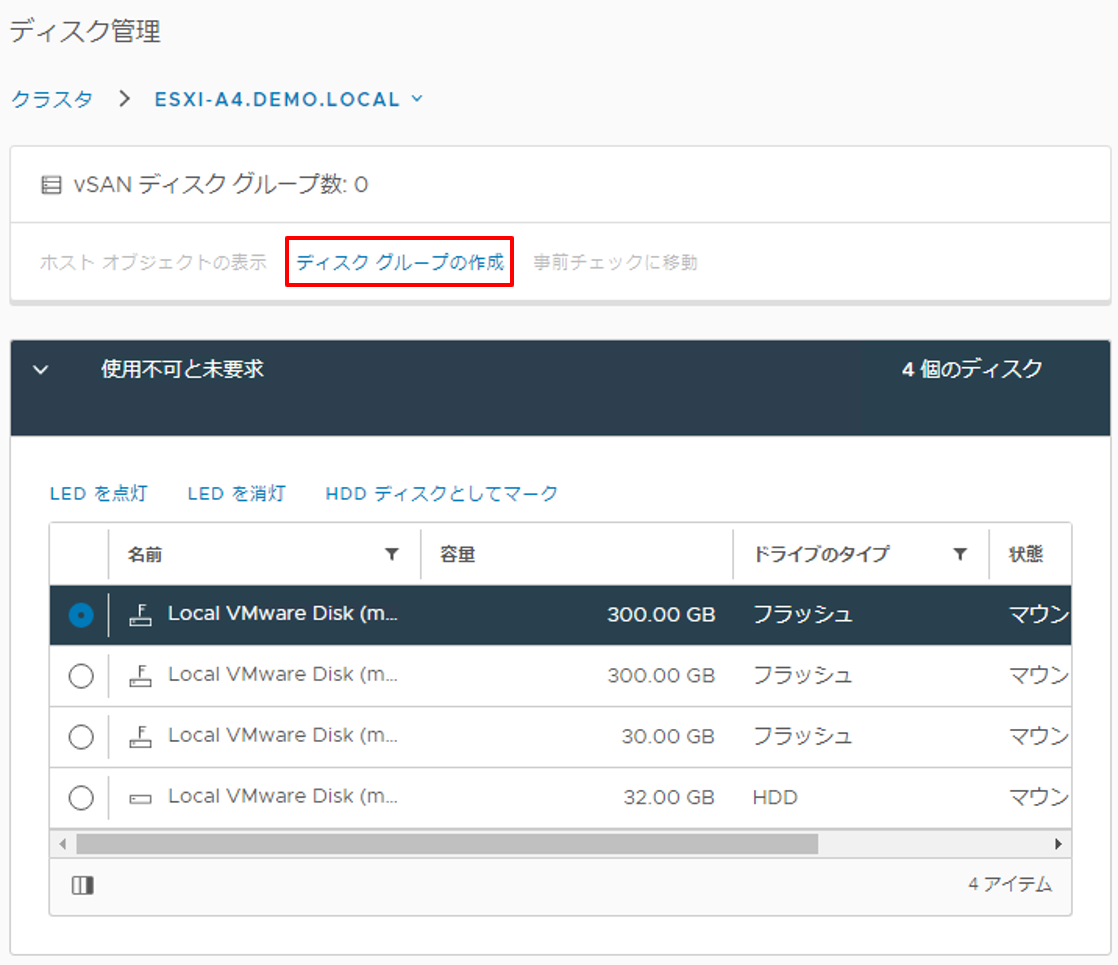

1. ディスクの管理画面にアクセスします。

|

|

2. [ディスク グループの作成] をクリックします。 |

|

3. キャッシュディスクおよびキャパシティディスクを選択します。

|

|

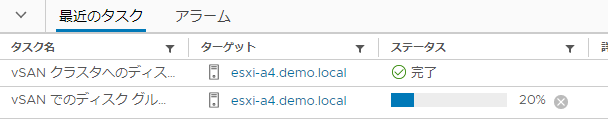

4. ディスクグループの作成が始まりますので、画面下部の [最近のタスク] で全てのタスクが完了するまで待ちます。全てのタスクが完了したら、ディスクグループの作成は完了です。 |

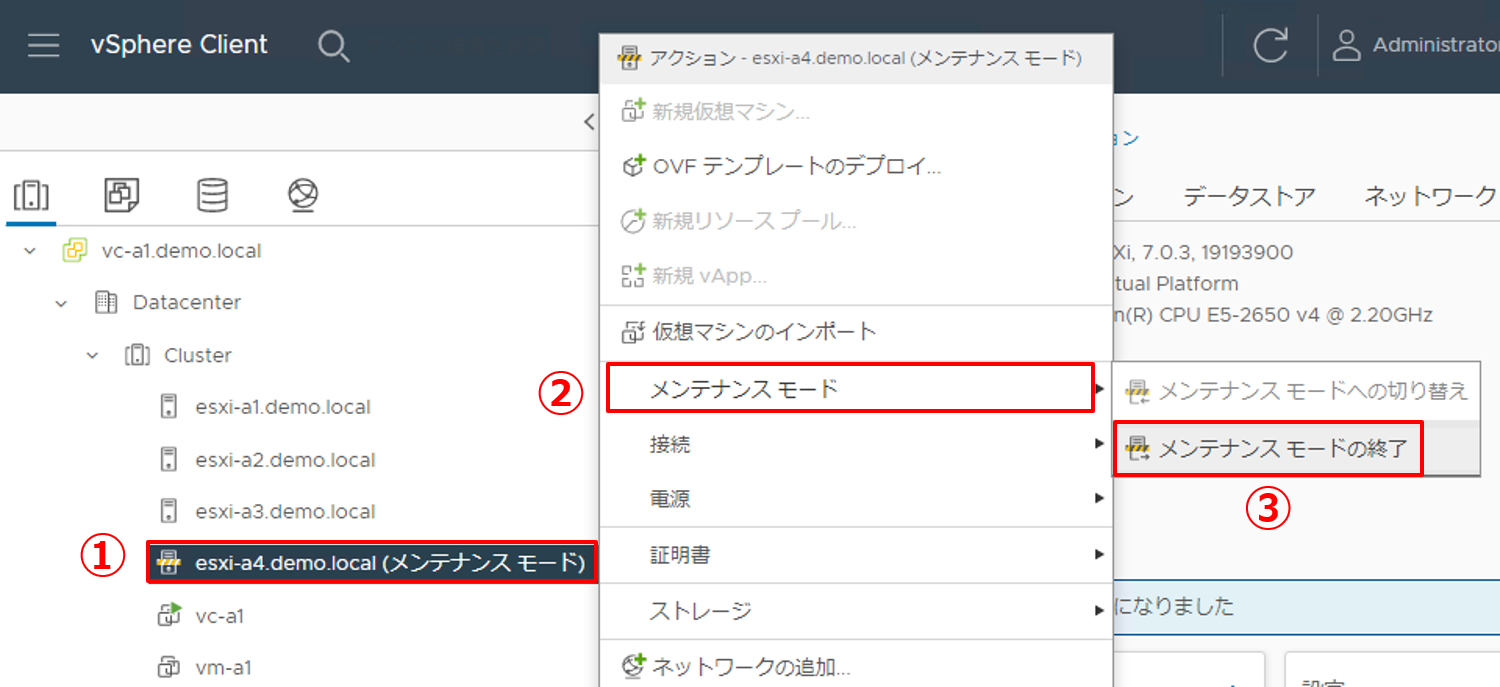

3.6 メンテナンスモードの終了(⑥)

ここまで全ての設定が完了したら、メンテナンスモードを終了します。Skyline健全性で他のESXiホストと通信がとれていることを確認します。また、vSANクラスターにホストを追加する前の合計リソースと比べて、どのように変化しているか確認します。

|

1. メンテナンスモードを終了します。

|

|

2. メンテナンスモードが終了したら、Skyline健全性を確認します。

|

|

3. vSANクラスター拡張後のリソース合計容量を確認します。

|

以上で、vSANクラスターの拡張は完了です。いかがでしょうか、vSANだからといって特別なことをしているわけではありません。ネットワーク設定やホスト追加作業等、vSphereの一般的な構築作業を行うだけでvSANクラスターを拡張できることがご理解いただけたかと思います。

4. Tips ~ スケールアップでの考慮点 ~

今回の記事ではvSANクラスターの拡張ということで、スケールアウトについてご紹介してきました。一方で、スケールアップによるストレージ容量の拡張も容易に行うことはできますが、vSANならではの設計も必要です。

スケールアップの設計で考慮するべき点は、「パフォーマンスを低下させないようにディスクグループを設計すること」です。

ひとつのディスクグループは1つのキャッシュディスクと複数のキャパシティディスクで構成されますが、キャッシュ容量と消費容量の比率が決まっており、その比率を考慮せずにキャパシティ容量だけ拡張するとvSANクラスターのパフォーマンスが向上しない可能性があります。消費容量とは、データを格納するために使用する予定の容量のことを指します。ストレージポリシー等で可用性を担保している状態であれば、物理容量よりも消費容量が小さくなります。

さて、キャッシュ容量と消費容量の間には以下のように一般的な推奨値があります。

キャッシュ容量 = 消費容量 × 10%

【参考】「vSANのハードウェア要件」

https://docs.vmware.com/jp/VMware-vSphere/7.0/com.vmware.vsphere.vsan-planning.doc/GUID-4B738A10-4506-4D70-8339-28D8C8331A15.html

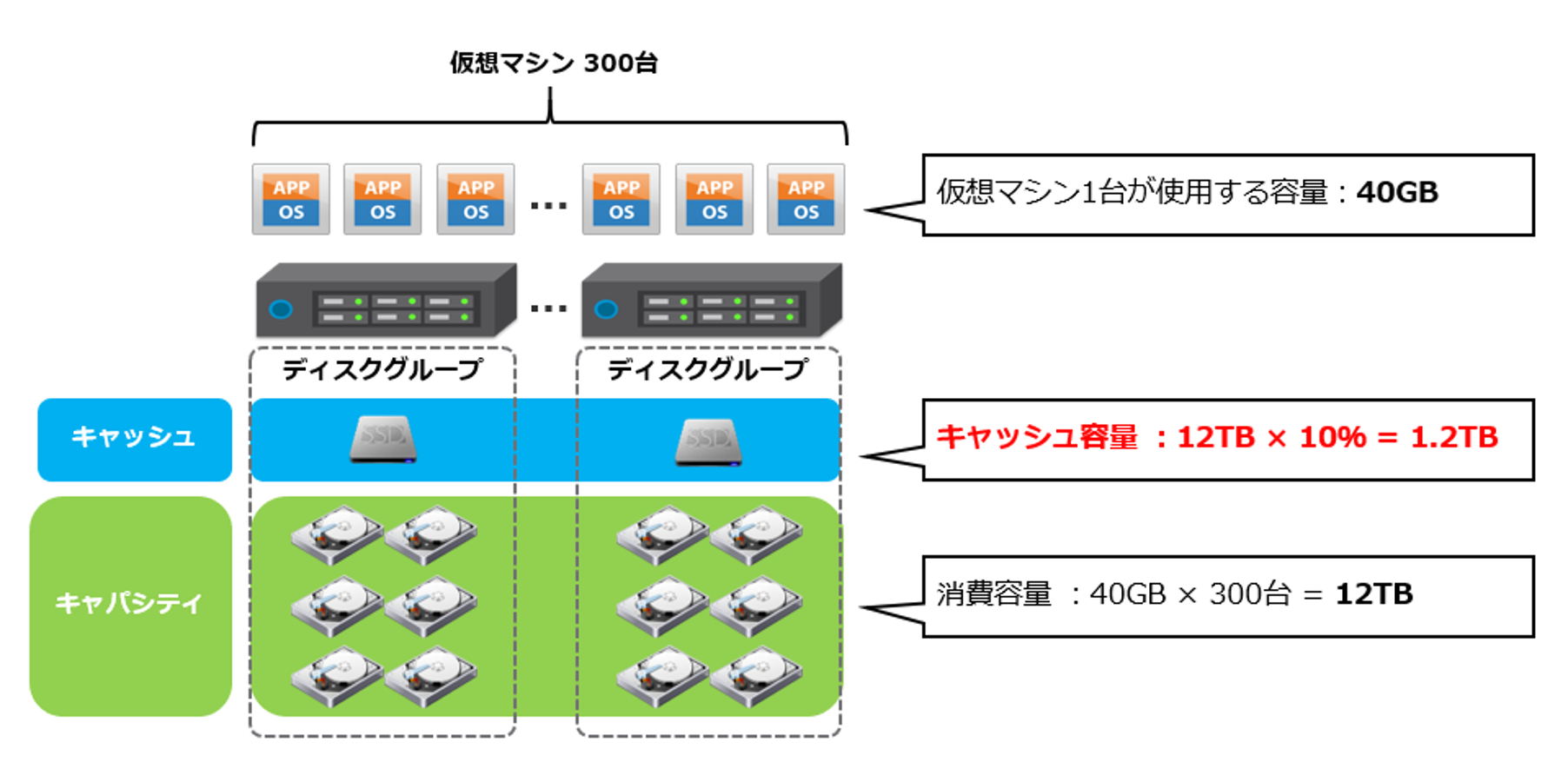

これが考慮するべき比率です。例えば、下図の例を見てみましょう。

まず、vSANクラスターで稼働させる仮想マシンの台数と容量から消費容量を算出します。消費容量を基に、vSANクラスター全体で必要となるキャッシュ容量を算出します。この構成の場合、消費容量12TBに対して、キャッシュ容量を1.2TBと算出できます。

もちろんこれはvSANクラスター全体で必要となる容量であるため、ホスト台数で割ることで、ホスト1台あたりのキャッシュ容量が算出できます。このようにして、比率を考慮した設計を前提にしてスケールアップを行う必要があります。

一般的にディスクグループを複数にすると、容量だけでなく性能が向上すると言われていますが、それだけキャッシュディスクに使用するSSDも必要となります。SSDはHDDに比べて高性能ですが高価でもあります。つまり、性能を重視するのか費用を重視するのか、あらかじめ要件を決定しておくとより設計しやすくなるでしょう。

以上、vSANクラスターの拡張についてご紹介しました。次回は、vSANの可用性に焦点をあてて、ストレージポリシーの設定についてご紹介します。是非ご覧ください!

【SB C&S主催】 VMware製品 無償セミナーのご案内

VMwareテクニカル講座

VMwareの各種製品の機能をわかりやすく学んでいただくために、「VMwareテクニカル講座」と題するWebセミナーを無償で開催しています。これからVMware製品を学び始める方向けに重要な機能を一通り紹介しています。詳細、お申し込みはこちらをご確認ください。

※パートナー様およびエンドユーザー様がご参加いただけます。

VMwareテクニカルハンズオン

VMwareテクニカル講座をベースにした、より実践的なハンズオンセミナーを無償で開催しています。詳細、お申し込みはこちらをご確認ください。

※パートナー様のみご参加いただけます。

皆様のご参加をお待ちしております。

他のおすすめ記事はこちら

著者紹介

SB C&S株式会社

ICT事業本部 技術本部 技術統括部 第1技術部 2課

湯村 成一 - Seiichi Yumura -

Dell Technologies・HPE製品担当のプリセールスエンジニア。

主に仮想化・HCIを専門領域としている。